您现在的位置是:首页 >其他 >(四)oobabooga加载Vicuna7b,vicuna13b,chatglm模型网站首页其他

(四)oobabooga加载Vicuna7b,vicuna13b,chatglm模型

文章目录

安装

环境:windows11

显卡:NVIDIA GeForce RTX 3090 version 526.98 显存 24G

Text generation web UI

https://github.com/oobabooga/text-generation-webui

下载 oobabooga-windows.zip 并解压G:llmoobabooga_windows,直接运行start_window.bat

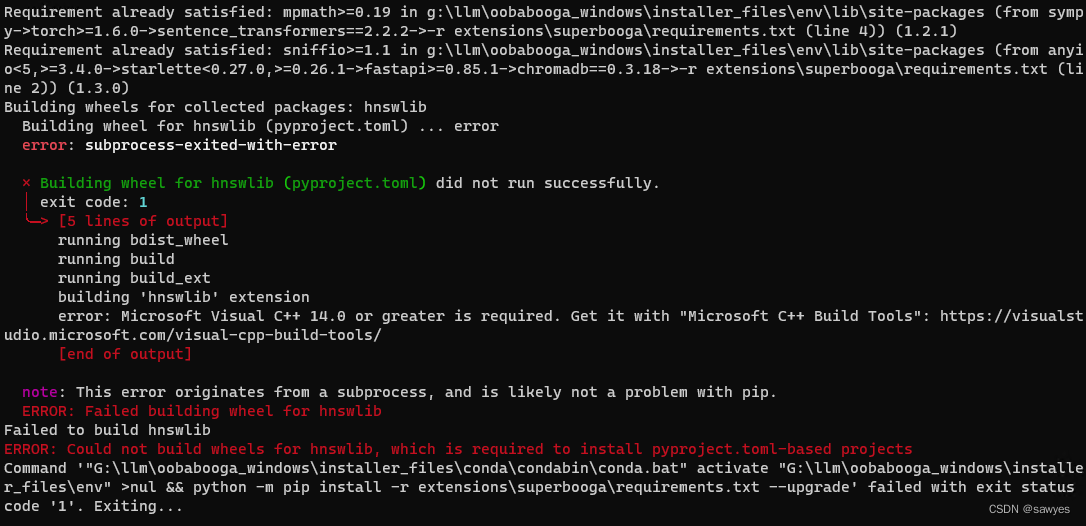

中途遇到报错

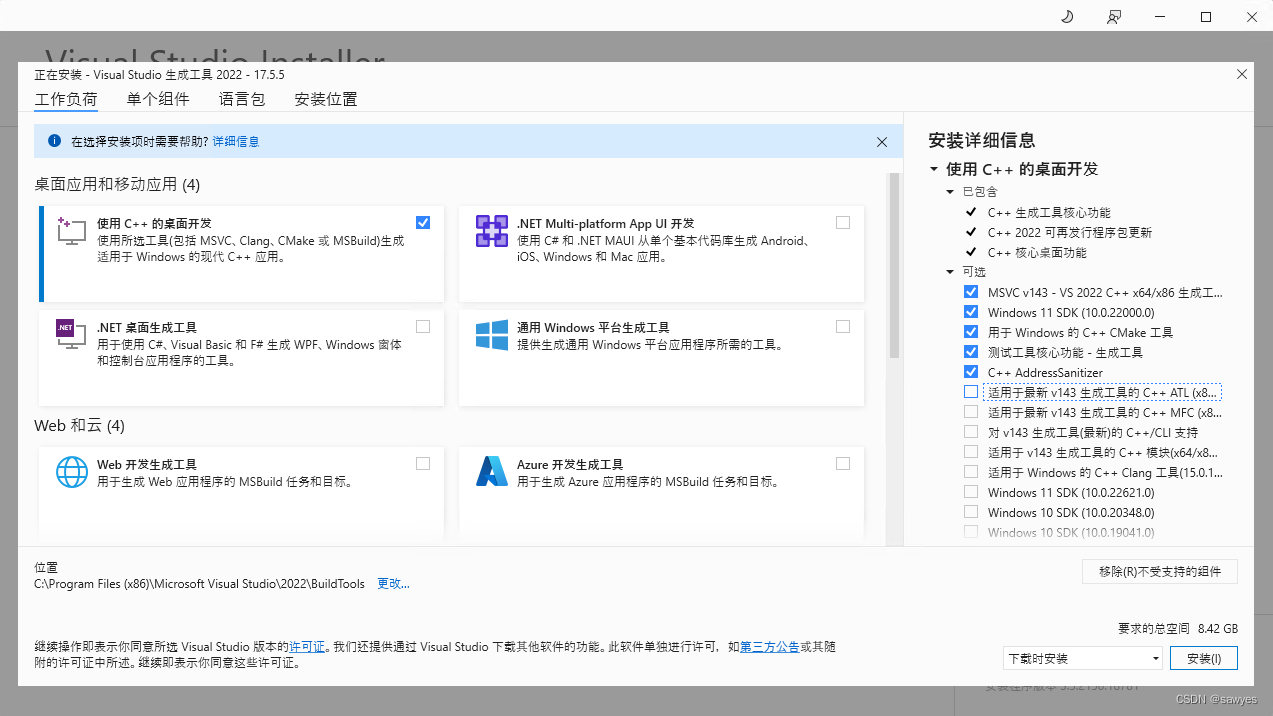

按照提示安装Visual C++ 14.0 ,安装地址在报错内容中有

error: Microsoft Visual C++ 14.0 or greater is required. Get it with "Microsoft C++ Build Tools": https://visualstudio.microsoft.com/visual-cpp-build-tools/

下载运行如下图,重点安装C++ CMake工具

备用:不用上述方法,其实可以安装几个依赖包解决,还没验证是不是这样可以解决

conda install libpython m2w64-toolchain -c msys2

修复上面问题后,把text-generation-webui删除掉,重新运行start_windows.bat, 这一步回到最后让你选择下载模型,我们关掉这个窗口,手动下载,往下看

加载不同的模型

huggingface 搜索模型页面 https://huggingface.co/models?sort=downloads

可以在启动的webui中切换不同模型,命令行效果如下图

vicuna 7b

Vicuna 的代码基于 Stanford Alpaca ,并额外支持多轮对话。 并且使用了与斯坦福羊驼(Stanford Alpaca)类似的超参数。

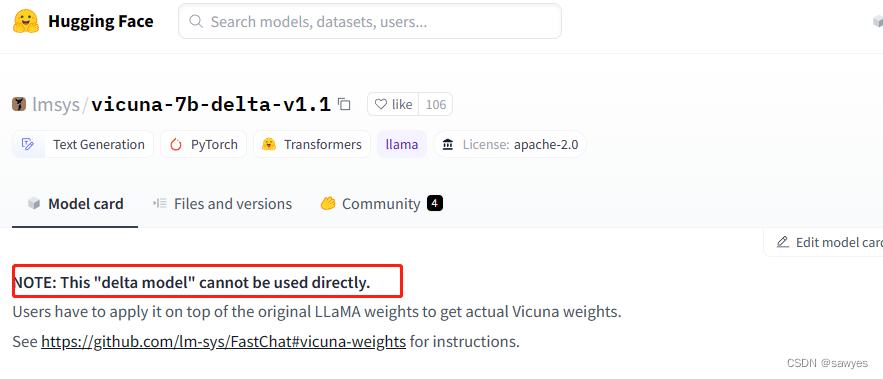

LLaMA-7b 模型不能直接使用(点击我查看详情),需要经历如下步骤

LLaMA-7b模型权重格式转换vicuna-7b-delta-v1.1和 转换后的模型合并

下载模型

# 下载这两个模型到任意目录

# 下载已经转换的llama权重

https://huggingface.co/decapoda-research/llama-7b-hf

# vicuna-7b

https://huggingface.co/lmsys/vicuna-7b-delta-v1.1

权重合并,生成vicuna-7b-all-v1.1 文件夹,最后复制到text-generation-webui/models模型目录下

# 安装fastchat

pip install fastchat

# vicuna权重合并

python -m fastchat.model.apply_delta

--base llama-7b-hf

--delta vicuna-7b-delta-v1.1

--target vicuna-7b-all-v1.1

在目录oobabooga运行start_windows.bat

vicuna-13b-GPTQ-4bit-128g(资源够的,可以直接vicuna-13b)

GPTQ这种一般直接加载就可以使用了,不像前面那么麻烦,用这个版本就是穷,什么东西自己百度好了

模型地址 https://huggingface.co/anon8231489123/vicuna-13b-GPTQ-4bit-128g

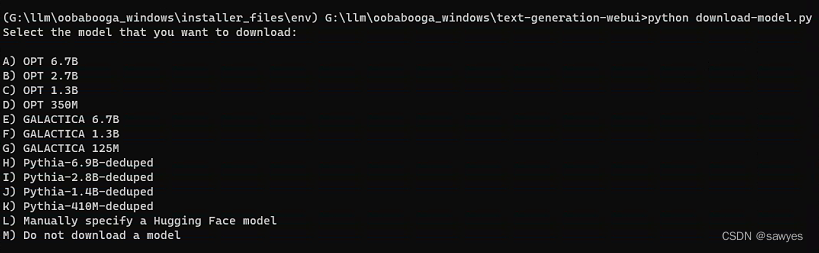

双击运行cmd_windows.bat文件

# 进入 text-generation-webui 目录

cd text-generation-webui

# 下载模型

python download-model.py

输入L

输入non8231489123/vicuna-13b-GPTQ-4bit-128g不用输入域名就会自动下载模型了,保存在models文件

耐心等待文件下载,然后关闭窗口,

在目录oobabooga运行start_windows.bat,到这里就结束了

chatglm6b

方法如上,下载模型就可以直接在目录oobabooga运行start_windows.bat,不再重复

https://huggingface.co/THUDM/chatglm-6b

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结