您现在的位置是:首页 >技术交流 >chatgpt如何接入本地知识库?我们来看看EMNLP 2022 INFO是如何融入本地知识的网站首页技术交流

chatgpt如何接入本地知识库?我们来看看EMNLP 2022 INFO是如何融入本地知识的

一、概述

title:You Truly Understand What I Need : Intellectual and Friendly Dialogue Agents grounding Knowledge and Persona

论文地址:You Truly Understand What I Need : Intellectual and Friendly Dialog Agents grounding Persona and Knowledge - ACL Anthology

代码地址:GitHub - dlawjddn803/INFO: Code for the paper "You Truly Understand What I Need : Intellectual and Friendly Dialogue Agents grounding Knowledge and Persona" which is accepted to EMNLP 2022 (Findings)

1.1 Motivation

1以前的研究将知识或个人资料混合融入预先训练的语言模型。其同时考虑知识和人物角色的能力仍然是有限的,导致生成结果出现幻觉,并且使用人物角色的方法也很被动。

1.2 Methods

1提出一种有效的agent,同时基于外部知识和persona。

2选择合适的知识和persona生成回答,利用poly-encoder的方法来实现候选打分。

3实施了人物角色级别指标,以考虑微妙的人物角色基础的多种人物角色选择。

4利用检索的方式来增强query,其包含知识-角色的增强信息,使其生成的回复少幻觉,多参与性。

5总结:1. 先计算persona和knowledge的分数 2. 选择合适的persona+knowledge 3. 结合2+query,检索相近的paragraphs 4. 生成更具信息量,更多参与度的responses。

1.3 Conclusion

1提出了INFO (Intellectual and Friendly dialOg agents),在persona-knowledge chat数据集自动评估metrics上取得sota。

2人工评估也显示其少幻觉,多参与性。

3相对于之前的检索器件retrievers,证明了我们retrievers的有效性,也比较了multiple candidate scoring的方法。

1.4 limitation

1缺乏真实的知识和persona候选,导致在现实环境不可用。

2评估幻觉的cases数量还比较少。

3需要高的GPU计算资源( since it marginalizes loss at the token level )

三、详细内容

3.1 整体架构图

主旨思想:利用对话历史信息,挖掘出最相近的背景信息,然后利用该信息检索出更多额外知识,进而提高生成结果的质量。

U:人类和机器的历史对话数据。

cand:每个候选,感觉是knowledge的候选 or persona的候选,目的是排序后选择分数最高的。

KPEQ(knowledge persona enhanced query):增强后的query

Retriever(Non parameters):非参数的,相当于是检索出相关文档,辅助额外的知识来提升回复效果。

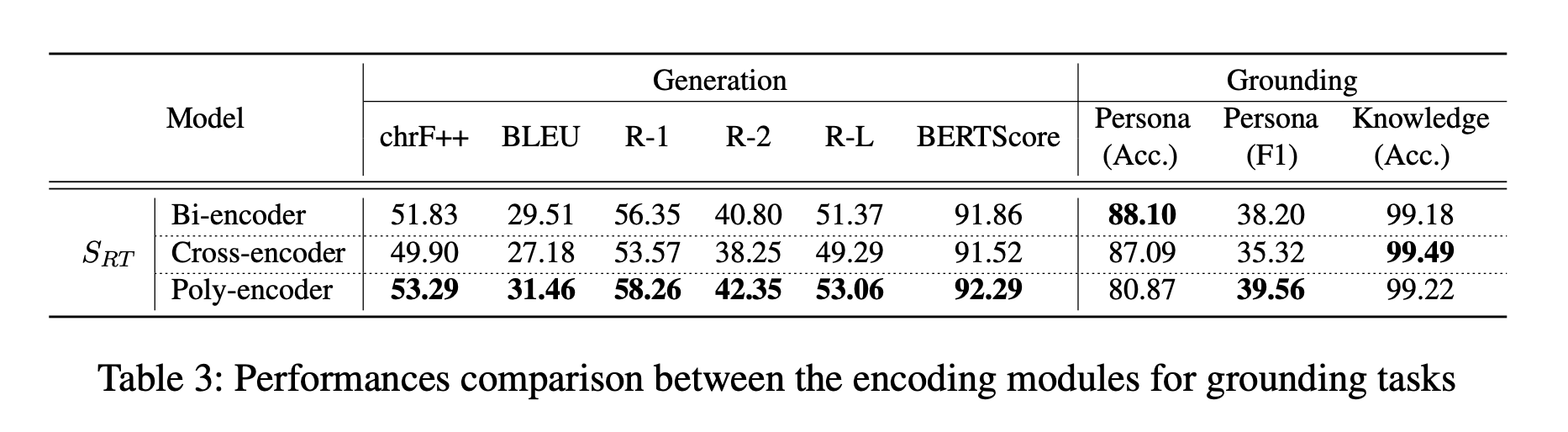

3.2 语义检索效果比较:相对于bi-encoder双塔和cross-encoder,poly这种交互模式效果最好

3.3 实验结果

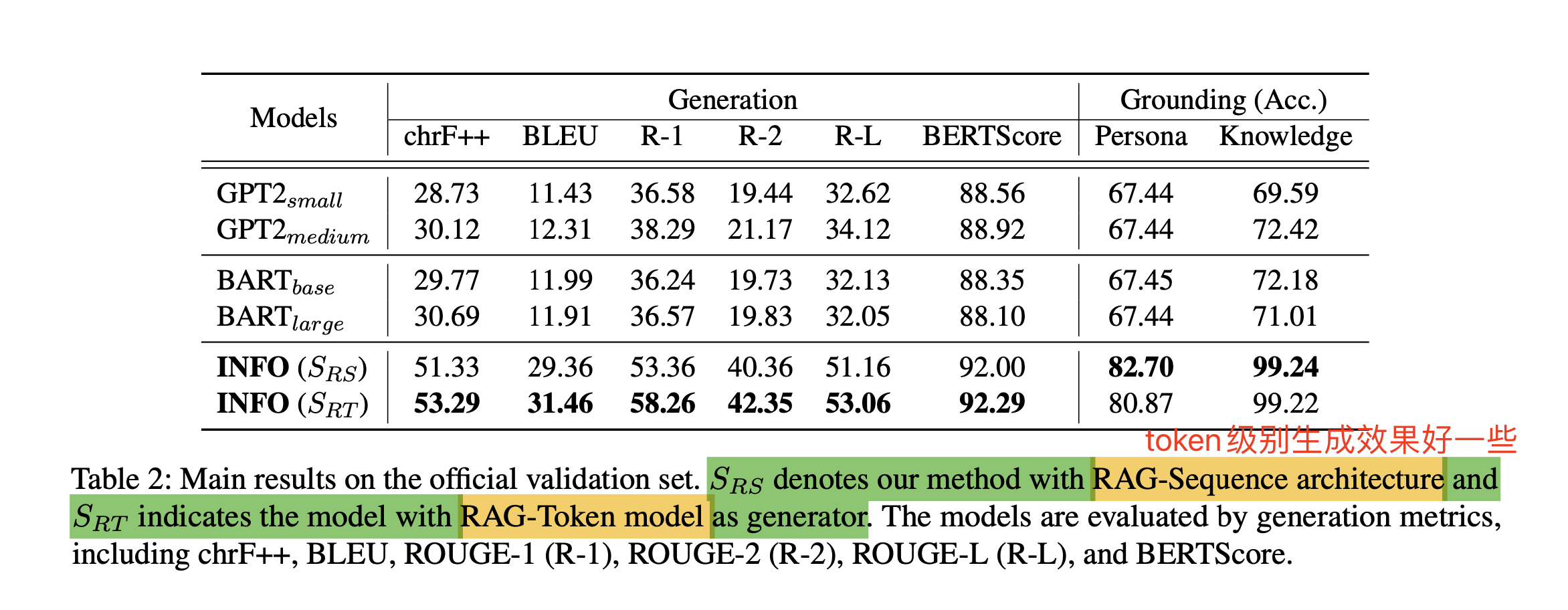

Generation:生成效果评估

Grounding:persona和knowledge分类预测的精度(挑选分数最高的persona和knowledge的精度吗?)

RAG:token级别生成效果好,sequence级别分类效果好

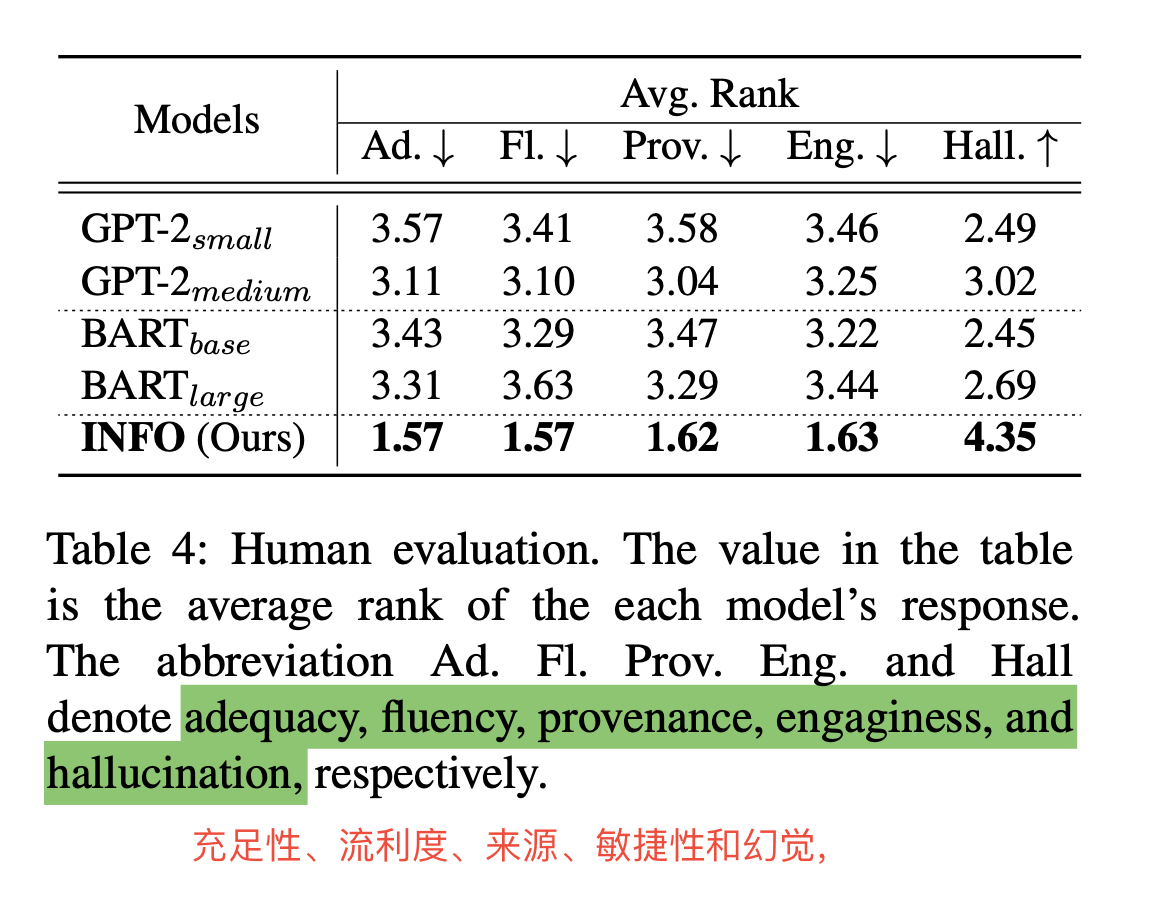

3.4 人工评估:效果碾压其他的

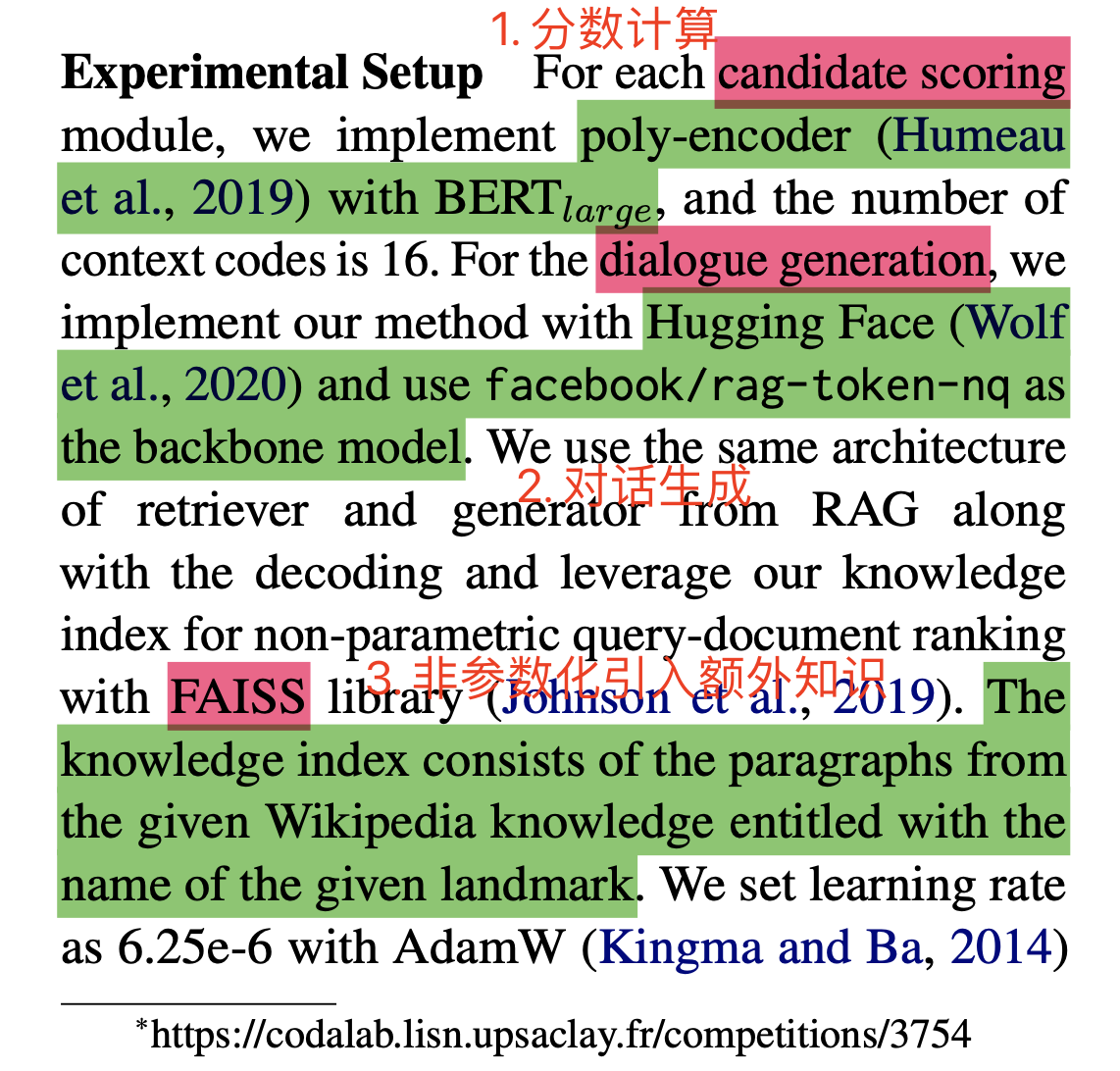

3.5 实验设置

U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... SpringSecurity实现前后端分离认证授权

SpringSecurity实现前后端分离认证授权