您现在的位置是:首页 >技术交流 >理解神经网络的注意力机制(Attention)及PyTorch 实现网站首页技术交流

理解神经网络的注意力机制(Attention)及PyTorch 实现

简介理解神经网络的注意力机制(Attention)及PyTorch 实现

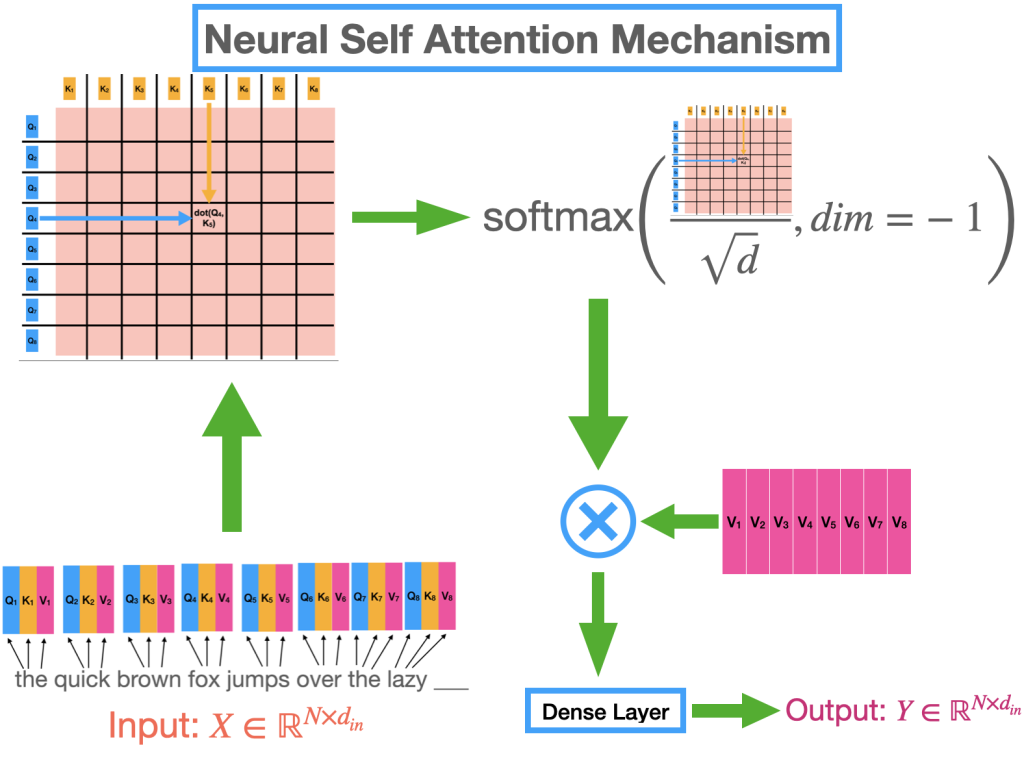

刚刚结束的 2022 年对于人工智能的许多进步来说是不可思议的一年。最近 AI 中的大多数著名地标都是由称为变形金刚的特定类别模型驱动的,无论是 chatGPT 的令人难以置信的进步,它席卷了世界,还是稳定的扩散,它为您的智能手机带来了类似科幻小说的功能。即使是 Tesla 的自动驾驶软件堆栈,也许是世界上部署最广泛的深度学习系统,也在引擎盖下使用变压器模型(双关语意)。“神经注意机制”是让 Transformer 在各种任务和数据集上如此成功的秘诀。

这是关于视觉转换器 (ViT) 的系列文章中的第一篇。在本文中,我们将了解注意力机制并回顾导致它的思想演变。接下来,我们就直观的了解一下。我们将从头开始在 PyTorch 框架中实现注意力机制,将直观的理解与数学细节结合起来,最终将这种理解转化为代码。尽管我们将在文章结尾专门讨论视觉转换器,但大部分讨论同样适用于大型语言模型 (LLM),例如 GPT-3 和最近发布的 chatG

风语者!平时喜欢研究各种技术,目前在从事后端开发工作,热爱生活、热爱工作。

U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结