您现在的位置是:首页 >其他 >苹果MR头显背后的秘密武器,ARKit演进历程一览网站首页其他

苹果MR头显背后的秘密武器,ARKit演进历程一览

苹果MR头显可以说是板上钉钉了,看了这么多的预测,几乎没有从ARKit的角度来看苹果头显的,因此本文我们将回顾ARKit近7年来的发展历程。

实际上,ARKit 3.5开始支持LiDAR(首个搭载的设备是iPad Pro 2020)就是为AR/VR头显筹备的重要一步,因为LiDAR可以实现更快距离探测实现即时AR交互,虚拟物体定位更精准,也带来了比如更逼真的遮挡效果提升沉浸感,还有更好的场景几何理解能力,为结合现实环境的MR交互提供基础。同时还有更重要的多物体AR交互能力,可以实现复杂AR场景。这些让苹果的AR体验实现了房间级的AR交互(实际上,这个概念至今没有多少媒体引用)。相关阅读:《iPad Pro新使命:开启房间级AR体验,iPhone、AR头显紧随其后》。

去年发布的ARKit 6基本就印证了苹果VST设备的策略,比如:支持4K分辨率显示、支持相机曝光调节、支持HDR录制等。以相机曝光调节为例,结合“数码旋钮”可以实现在VR和AR无缝切换能力,这个功能也是近半年被爆出苹果MR的一个重磅功能。其它功能也基本围绕“视频透视”的能力展开,非常容易联想到VST模式。相关阅读:《WWDC22:ARKit 6低调发布,新功能瞄准VST MR头显》

虽然说ARKit在iPhone和iPad并没有激起波澜,但将在苹果AR/MR头显上发挥重要作用。而且因苹果具备极强的软硬件整合能力,这些AR能力至今都是业内一流。

从2017年开始,苹果每年都会在WWDC活动上发布新版ARKit,截止去年已经更新迭代至ARKit 6,今年WWDC不出意外苹果MR头显即将发布。那么在此之前,也许我们可以通过ARKit的技术演变,来看看苹果的AR/VR策略,甚至猜猜未来哪些可能会体现在头显硬件上。

ARKit重要功能一览

ARKit 1(iOS 11)

第一个版本的ARKit支持的功能不多,但在当时是开创性的,它用法简单、性能优秀,允许开发者iPhone、iPad打造AR应用。ARKit 1使用视觉惯性里程计(VIO,一种融合相机和IMU数据实现SLAM的算法)来追踪周围物理场景,无需额外校准,就能可靠提取基于初始点的位置和方向变化。

此外还支持光照估计和渲染(由来优化AR外观),以及场景理解功能,比如检测水平面,并使用iPhone X的前置摄像头追踪人脸。通过ARKit 1,开发者可以将虚拟家具放置在真实场景中,或是允许用户在餐厅中踢AR足球。而面部追踪功能,则让Snapchat等AR滤镜更容易实现。

ARKit 1在A9和A10处理器上运行,支持Metal、SceneKit、Unity、Unreal等3D渲染引擎。

ARKit 1.5(iOS 11.3)

此前,ARKit 1只能识别桌面、椅子等水平表面,而ARKit 1.5则加入对墙体、房门等垂直表面的识别支持,允许开发者在垂直表面上固定AR内容。此外借助计算机视觉技术,对圆形家具等不规则表面的检测效果更准确,也能识别空间内的标志、海报、插图、二维码等2D图像,并调出对应的AR内容。

本次更新还改进了AR整体的质量,比如图像分辨率提升50%,支持自动对焦,更准确的房间测绘,让AR内容看起来更真实。

ARKit 2(iOS 12)

在WWDC 2018上,推出ARKit 2,还推出了一个与皮克斯合作开发的AR格式:USDZ,以及AR快速预览功能(AR Quick Look)。

ARKit 2性能升级部分:1,改进的人脸追踪效果;2,更逼真的渲染处理能力;3,3D控件检测能力;4,对象持久保持的能力;5,可共享的多人AR能力(基于本地设备到设备的数据传输,非云端。现场演示了乐高多人AR游戏)。

据了解,皮克斯此前曾开发可扩展的开源3D说明文件格式:USD,而USDZ则是针对AR的文件格式,特点是采用嵌入式设计,可快速预,目的是为了简化AR文件的访问和共享流程,而通过嵌入到app或网页中,可以很好的打通苹果全家桶生态。

苹果还推出了AR测量app《Measure》,可使用相机视觉预测物体尺寸、体积等数据,比如相框中相片的大小。

ARKit 3(iOS 13)

在WWDC 2019上,苹果不仅推出ARKit 3,还发布两个新的AR开发工具:RealityKit和Reality Composer,目的是补充ARKit,简化3D场景创建,提高AR交互场景的开发速度和效率。

ARKit 3更新包括:同时使用前置和后置相机来定位、动作捕捉、人体遮挡、更快的参考图像载入、自动识别图像尺寸、视觉连贯性、更稳定的3D物体识别、多人面部追踪、多人实时协作、识别高达100张图像、HDR环境纹理、AR Coaching UI,以及AR快速预览支持更多机型,并支持录制视频、启动Apple Pay、空间音频等功能

RealityKit可以在真实场景中以AR形式展示3D控件,从而快速实现AR场景融合。该工具主要有5大亮点:1,照片级渲染效果;2,支持环境和相机特效;3,支持动画、物理、音频等特效;4,整合ARKit;5,原生支持Swift API。

而Reality Composer则是一个3D场景创建工具,特点是通过拖拽、点击等简单操作,即可生成交互式AR场景。该工具内置大量3D内容数据库,还可与Xcode和iOS应用配合使用,从而实现AR场景快速预览、微调,大幅提升效率。

ARKit 3.5(iOS 13.4)

随着搭载LiDAR传感器的iPad Pro在2020年发售,苹果也推出了ARKit 3.5,其中包含了多个功能:场景几何(Scene Geometry)API、即时AR体验,此外还改进了动作捕捉和人体遮挡功能。这些功能和特性基于LiDAR硬件来实现,因此仅支持搭载LiDAR的iPad或iPhone型号。

场景几何API:可实时捕捉场景中的3D物体(地板、墙壁、天花板、窗户、门、桌椅),并构建3D场景模型,提升整个场景的3D识别能力。

即时AR体验:在开启AR模式时,无需左右扫描场景即可快速、实时放置AR对象。

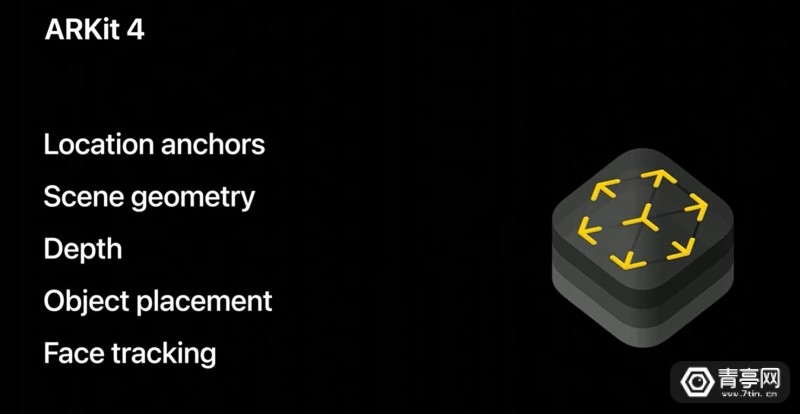

ARKit 4(iOS 14)

从ARKit 3.5开始,ARKit的新功能主要围绕LiDAR等硬件技术展开,在此基础上,ARKit 4小幅更新,主要带来以下功能:深度API、位置锚定、AR视频纹理,同时面部追踪支持更多设备。

深度API:通过LiDAR对每个像素的深度信息进行分析,并与场景几何的3D网格数据结合使用,让虚拟物体与现实物体的融合更逼真、自然。同时,还可进一步提升AR测距应用的准确性;

位置锚定:基于Apple Maps数据,可将高分辨率AR内容(LBS AR)持续固定在现实场景/位置,例如一个著名景区,通过位置锚定即可为AR虚拟物体加上经纬度、海拔等信息,从而与地理位置永久性的融合。

此前,ARKit 2已经支持持久性AR,与位置锚定不同的是,持久性AR基于保存与加载地图特性,利用了视觉定位,而没有结合地图GPS数据。

视频纹理:可将视频纹理添加到RealityKit场景中任意部分,让物理对象、表面、人物看起来更生动。

面部追踪扩展:支持使用A12 Bionic及更新芯片的设备,但在特定的设备上,面部识别功能依然受限,比如iPhone SE仅支持单用户追踪,而具备原深感相机TureDepth的设备可同时识别追踪三个人脸信息。

ARKit 5(iOS 15)

在WWDC 2021期间,苹果低调更新了ARKit 5,同时也推出了RealityKit 2。

ARKit 5新功能主要有四点:1,位置锚定支持更多地区;2,人脸追踪功能升级(支持更多A12芯片设备,在配备深感相机设备中,支持3人面部追踪);3,改进运动追踪;4,AR绑定App Clip Code二维码。

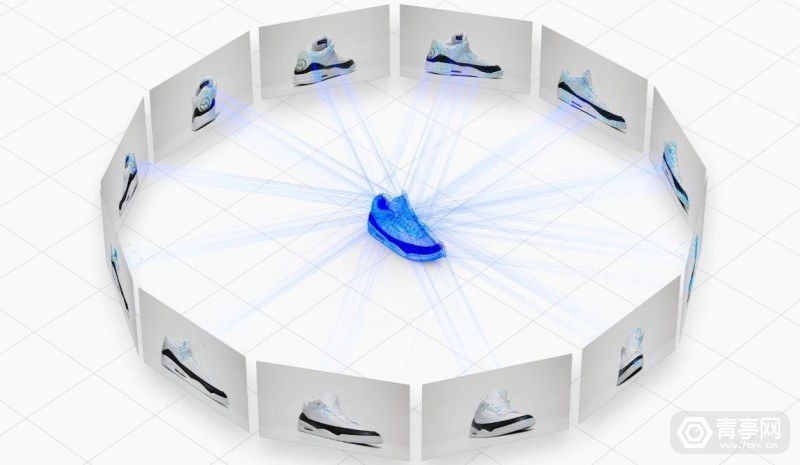

而RealityKit 2新功能则包括:1,3D扫描(Object Capture API);2,自定义着色器;3,动态加载方式;4,系统模块定制;5,虚拟角色控制器。

Object Capture API是RealityKit 2的一大亮点,该功能旨在统一、简化3D扫描和建模的流程,同时更加充分利用LiDAR能力。据称,该API可在几分钟内输出USDZ格式的高质量3D模型,支持AR快速预览,也可以导入Reality Composer等其他工具。

ARKit 6(iOS 16)

在WWDC 2022期间,苹果依旧低调更新ARKit 6,本次更新的重磅功能包括:4K分辨率,HDR录制,实时调节相机曝光、白平衡等参数,这些功能对VST透视AR体验相当重要,未来能否应用于苹果MR头显则令人期待。此外,还加入了前摄+后摄融合玩法,可通过前摄捕捉人脸,然后基于后摄拍摄背景,实现一些另类的玩法和交互。

现有的功能也得到优化:改进了运动追踪,现支持识别左右耳朵,优化了姿态检测功能,可以自动估算好拍摄场景中物体的大小,并实现稳定的追踪效果,提高3D物体检测的鲁棒性。

ARKit 6依然只是小幅更新,一方面是因为该技术本身已经领先竞争对手,另一方面,按照苹果的设计思路,软件方面新功能大概率需更强大的硬件做支撑。

4K分辨率、HDR录制可为视频拍摄和分享、电影制作等场景带来价值,与此同时,也可以实现更好的VST混合现实效果。以往在谈到移动AR时,更多关注的是3D AR内容的清晰度、逼真度,以及与物理场景的自然交互/融合。而实际上,移动ARden视频背景清晰度也同样重要,对于VST头显来讲更是如此,清晰的视频透视可减少长时间体验的视觉疲劳。此外,ARKit 6带来的实时调节相机曝光、白平衡、对焦功能,对于沉浸式AR体验也很重要,比如可以把现实场景调暗等等操作。

甚至,如果还可以设置不同的焦点切换(这一点暂时没有明确),还能基于此实现引导注意力转移等玩法,对MR游戏的虚实融合类交互帮助很大,想象空间很大。

苹果还发布了新的AR工具:RoomPlan API,特点是基于ARKit和Swift API,硬件基于LiDAR设备,可通过扫描房屋场景进行3D规划,适用于房地产、建筑、室内设计、电子商务、酒店管理等行业。扫描后可导出USD或USDZ格式文件,文件中信息包括:房间中识别到的组件尺寸,家具类型等,并可在C4D、AutoCAD、Shapr3D等进一步编辑。

至此,苹果AR生态由5大套件组成:ARKit、RealityKit、RoomPlan、AR创作工具(Reality Composer、Reality Converter、Xcode和USDZ工具)和AR Quick Look。

在LBS AR、VPS领域,苹果也有布局,但全新设计的苹果地图在全球覆盖率上不如谷歌地图。比如此前苹果曾推出类似谷歌街景的Look Around功能,可实现基于VPS原理的AR导航等功能,但AR导航仅支持十几个城市。

此外,苹果在WWDC 2022上还推出了MapKit,允许开发者在AR应用中调用原生地图能力,推动LBS AR应用。

从ARKit的一次次更新中,一个重点是打通3D内容格式(USDZ),另一方面则是利用LiDAR模组优化AR性能。如无意外,苹果未来的AR/VR头显也将支持大量的LiDAR功能和应用。比如可以预见的是,图像识别、文字语言翻译、单位转换、价格识别等基于摄像头的玩法,未来很可能会作为MR/AR头戴设备的基础功能。

由此可见,ARKit打磨6-7年时间,苹果借助现有硬件已经支持相机动态调焦,以及曝光、白平衡等参数调节。而且,在相机、视频录制上有明显优势,显然苹果的VST方案上限可能会很高,就像是早年间的安卓手机和iPhone拍照的差别。接下来,苹果要做的就是AR/VR头显端的内容生态,这也直接影响着用户对这款产品的关注程度。

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结