您现在的位置是:首页 >学无止境 >【大数据之Hadoop】三十、HDFS故障排除网站首页学无止境

【大数据之Hadoop】三十、HDFS故障排除

使用3台服务器,恢复yarn快照。

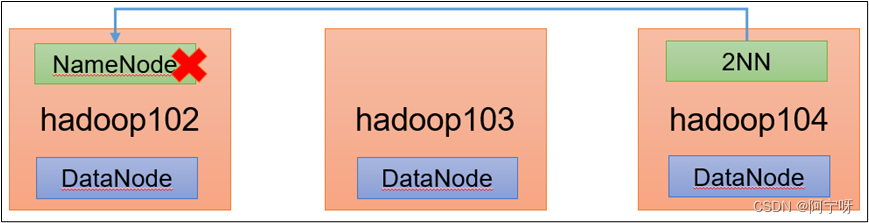

1 NameNode故障处理

出现NameNode进程挂了并且存储的数据也丢失了,怎么恢复NameNode。

故障模拟:

(1)kill掉NameNode的进程:

kill -9 进程ID

(2)删除NameNode的数据:/opt/module/hadooop-3.3.1/data/dfs/name

rm -rf /opt/module/hadooop-3.3.1/data/dfs/name/*

故障恢复:

(1)拷贝SecondaryNameNode中的数据到NameNode存储目录下:

scp -r liaoyanxia@hadoop104:/opt/module/hadoop-3.3.1/data/dfs/namesecondary/* ./name/

(2)重启NameNode:

hdfs --daemon start namenode

(3)向集群上传一个文件,成功!

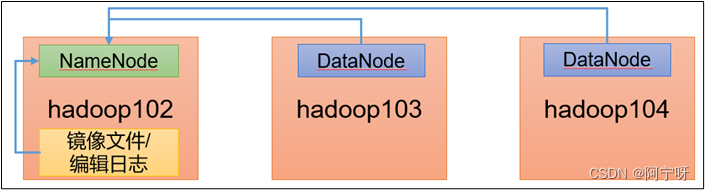

2 集群安全模式&磁盘修复

安全模式的状态:文件系统只能进行读操作,不能删除、修改等。

进入安全模式的场景:

(1)NameNode在加载镜像文件和编辑日志时(集群刚启动或者系统刚启动时会进入到安全模式)。

(2)NameNode在接收DataNode注册时。

退出安全模式的条件:

(1)dfs.namenode.safemode.min.datanodes:最小可用datanode数量,默认0

(2)dfs.namenode.safemode.threshold-pct:副本数达到最小要求的block占系统总block数的百分比,默认0.999f。(只允许丢一个块)

(3)dfs.namenode.safemode.extension:稳定时间,默认值30000毫秒,即30秒。

基本语法:

集群处于安全模式,不能执行重要操作(写操作)。集群启动完成后,自动退出安全模式。

(1)bin/hdfsdfsadmin -safemode get (功能描述:查看安全模式状态)

(2)bin/hdfsdfsadmin -safemode enter (功能描述:进入安全模式状态)

(3)bin/hdfsdfsadmin -safemode leave (功能描述:离开安全模式状态)

(4)bin/hdfsdfsadmin -safemode wait (功能描述:等待安全模式状态)

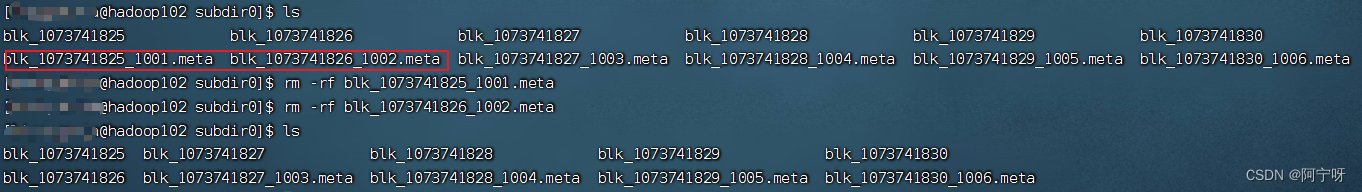

案例1:磁盘修复:当数据损坏进入安全模式时怎么处理:

(1)分别进入hadoop102、hadoop103、hadoop104的/opt/module/hadoop-3.1.3/data/dfs/data/current/BP-…/current/finalized/subdir0/subdir0目录,统一删除某2个块信息(.meta后缀)。

删除之后集群没有任何反应的原因:

NameNode和DataNode的工作机制:在集群启动之后,由DataNode主动向NameNode汇报,等到6小时间隔再汇报一次,当把数据块损坏时,得至少过6小时NameNode才会知道DataNode有无汇报。

修复方法:重启集群。

(2)重启集群。

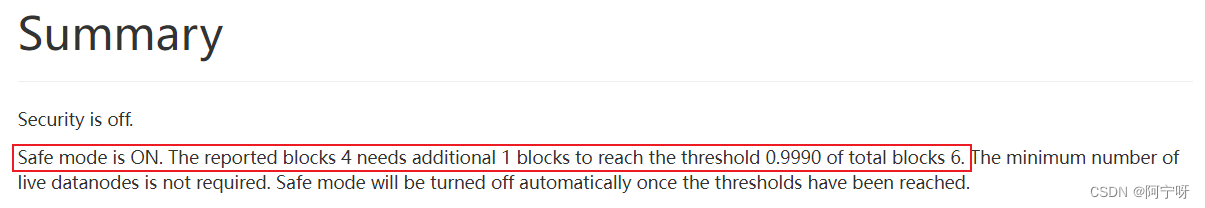

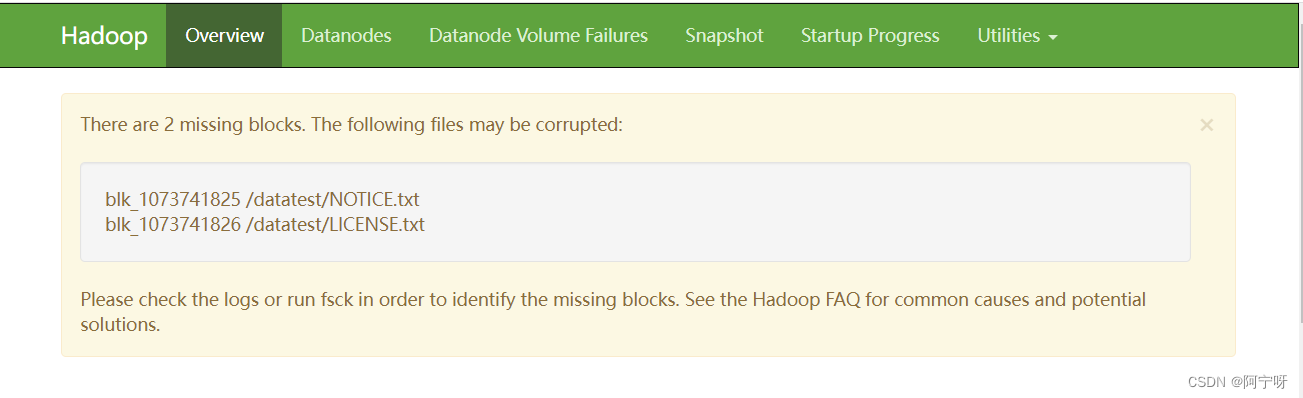

(3)观察http://hadoop102:9870/dfshealth.html#tab-overview

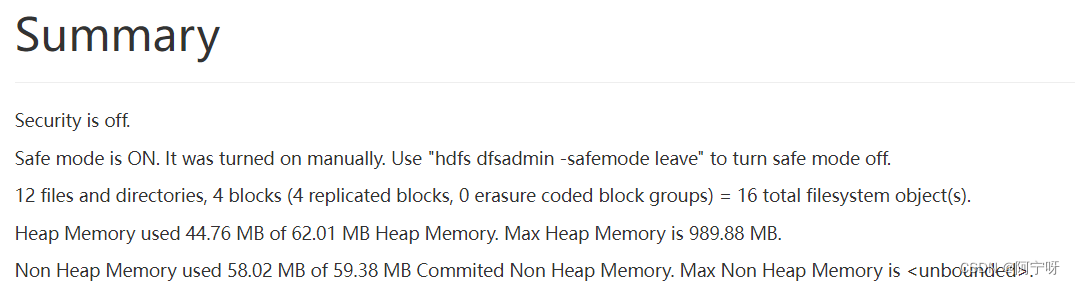

说明:安全模式已经打开,块的数量没有达到要求,且一直处于安全模式。

(4)离开安全模式:

hdfs dfsadmin -safemode get

hdfs dfsadmin -safemode leave

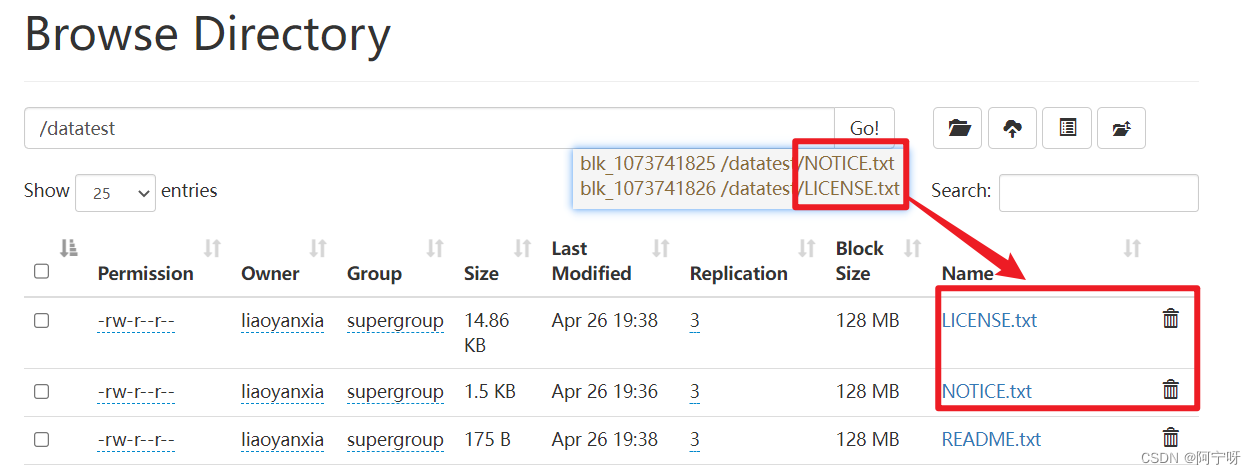

(5)安全模式关闭后,观察http://hadoop102:9870/dfshealth.html#tab-overview,发现丢失两个块。

此时可以对集群进行工作,但下次再启动集群时还是会进入到安全模式,任何关掉安全模式后还是会提示丢失块。

方法一:由专业人士修复丢失的块,在恢复块之前不能对集群有任何操作。

方法二:如果该块不重要,则可以在HDFS删除元数据。

(6)用方法二在HDFS删除上述目录下的元数据。

(7)重启集群,观察http://hadoop102:9870/dfshealth.html#tab-overview,集群已经正常。

案例2:模拟等待安全模式,只有在安全模式退出之后才能继续进行操作。

(1)查看当前模式:

hdfs dfsadmin -safemode get

(2)先进入安全模式:

bin/hdfs dfsadmin -safemode enter

(3)在/opt/module/hadoop-3.3.1路径上创建并执行脚本safemode.sh,执行完该脚本之后数据并没有上传到HDFS中。

vim safemode.sh

#!/bin/bash

hdfs dfsadmin -safemode wait

hdfs dfs -put /opt/module/hadoop-3.3.1/README.txt /

chmod 777 safemode.sh

./safemode.sh

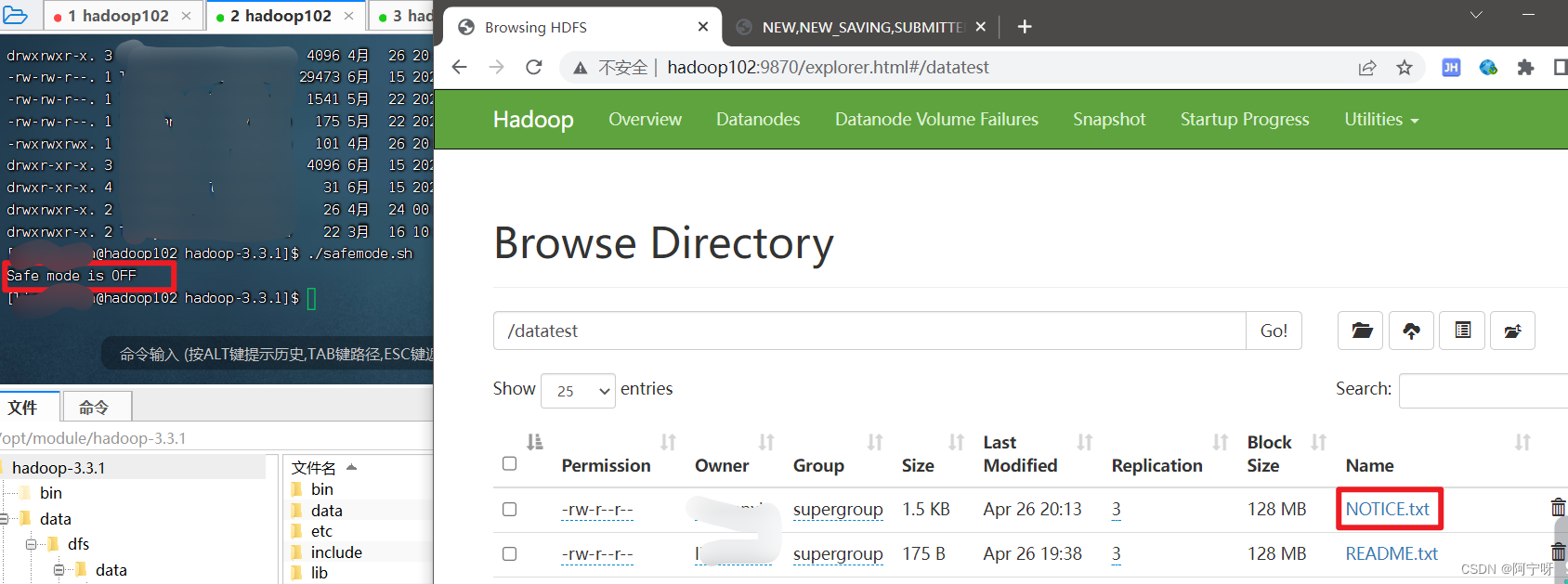

(4)在另外一个窗口执行执行安全模式退出。

bin/hdfs dfsadmin -safemode leave

(5)观察原来的窗口显示安全模式退出。

Safe mode is OFF

(6)观察到HDFS集群上数据上传成功。

3 慢磁盘监控

指写入数据非常慢的磁盘。当机器运行时间长了,任务运行多,磁盘读写能力退化,严重时出现写入数据延时问题。

发现慢磁盘的办法:

在HDFS创建一个目录,正常需要不到1s的时间,若创建目录大于1min且不是每次都是,知识偶尔慢,就可能出现慢磁盘。

找出哪块是慢磁盘的方法:

1)心跳未联系时间

慢磁盘会影响DataNode和NameNode之间的心跳,正常心跳时间间隔是3s,超过3s则异常。

2)fio命令,测试磁盘读写性能

先下载fio:sudo yum install -y fio

(1)顺序读测试

sudo fio -filename=/home/liaoyanxia/test.log -direct=1 -iodepth 1 -thread -rw=read -ioengine=psync -bs=16k -size=2G -numjobs=10 -runtime=60 -group_reporting -name=test_r

(2)顺序写测试

sudo fio -filename=/home/liaoyanxia/test.log -direct=1 -iodepth 1 -thread -rw=write -ioengine=psync -bs=16k -size=2G -numjobs=10 -runtime=60 -group_reporting -name=test_w

(3)随机写测试

sudo fio -filename=/home/liaoyanxia/test.log -direct=1 -iodepth 1 -thread -rw=randwrite -ioengine=psync -bs=16k -size=2G -numjobs=10 -runtime=60 -group_reporting -name=test_randw

(4)混合随机读写

sudo fio -filename=/home/liaoyanxia/test.log -direct=1 -iodeth 1 -thread -re=randrw -rwmixread=70 -ioengine=psync -bs=16k -size=2G -numjobs=10 -runtime=60 -group_reporting -name=test_r_w -ioscheduler=noop

4 小文件归档

小文件弊端:

因为每个文件按块存储,每个块都存储在NameNode中,大概占150Byte,所以对于100个1k的文件块和100个128m的文件块,所占的NameNode内存大小都为100*150Byte。大量小文件会占用很多NameNode内存。

解决:

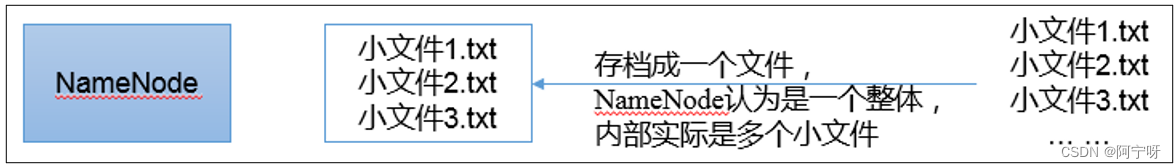

HDFS存档文件或HAR文件,把文件存入HDFS块,在减少NameNode内存使用的同时,允许对文件进行透明的访问。(即HDFS存的文件对内还是一个一个独立文件,对NameNode而言却是一个整体,减少了NameNode的内存。

先开启集群:

myhadoop.sh start

归档文件:

把/input目录里面的所有文件归档成一个叫input.har的归档文件,并把归档后文件存储到/output路径下。

hadoop archive -archiveName input.har -p /input /output

查看归档文件:

hadoop fs -ls /output/input.har

hadoop fs -ls har:///output/input.har 可以看到归档文件里的一个个文件

解归档文件:

hadoop fs -cp har:///output/input.har/* /

U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结