您现在的位置是:首页 >技术杂谈 >【论文导读】- A vertical federated learning framework for graph convolutional network(一种用于图卷积网络的纵向联邦学习框架)网站首页技术杂谈

【论文导读】- A vertical federated learning framework for graph convolutional network(一种用于图卷积网络的纵向联邦学习框架)

论文信息

A vertical federated learning framework for graph convolutional network

原文地址:A vertical federated learning framework for graph convolutional network:https://arxiv.org/pdf/2106.11593.pdf

摘要

Recently, Graph Neural Network (GNN) has achieved remarkable success in various real-world problems on graph data. However in most industries,data exists in the form of isolated islands and the data privacy and security is also an important issue.In this paper, we propose FedVGCN, a federated GCN learning paradigm for privacy-preserving node classification task under data vertically partitioned setting, which can be generalized to existing GCN models. Specifically, we split the computation graph data into two parts. For each iteration of the training process, the two parties transfer intermediate results to each other under homomorphic encryption. We conduct experiments on benchmark data and the results demonstrate the effectiveness of FedVGCN in the case of GraphSage.

最近,图神经网络( Graph Neural Network,GNN )在图数据上的各种实际问题中取得了显著的成功。然而在大多数行业中,数据以孤岛的形式存在,数据的隐私安全也是一个重要问题。在本文中,我们提出了一种联邦GCN学习框架FedVGCN,用于数据垂直分区设置下的隐私保护节点分类任务,该范式可以推广到现有的GCN模型中。具体地,我们将计算图数据拆分为两部分。对于训练过程的每一次迭代,双方在同态加密下相互传递中间结果。我们在基准数据上进行了实验,结果证明了FedVGCN在GraphSage情况下的有效性。

Contributions

- 在隐私保护的环境下为图卷积网络引入了一种纵向联邦学习算法,为现有联邦学习方法无法解决的联邦问题提供解决方案;

- 提供了一种新的方法,采用加法同态加密( HE )来确保隐私,同时保持准确性。在3个基准数据集上的实验结果表明,我们的算法显著优于在孤立数据上训练的GNN模型,并取得了与在组合明文数据上训练的传统GNN相当的性能。

Preliminaries

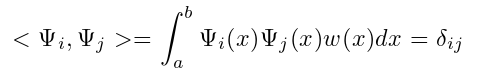

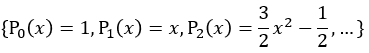

正交多项式

区间[ a , b]内的函数集合{ Ψ0,Ψ1,…,Ψn }是关于权函数Ω的一组正交函数,如果

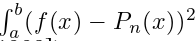

最小二乘逼近

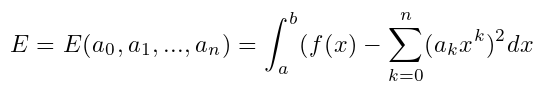

假设f ∈ C[a, b],找到一个至多n次的正交多项式Pn ( x )来逼近f,使得 最小。

最小。

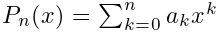

令多项式 使误差最小:

使误差最小:

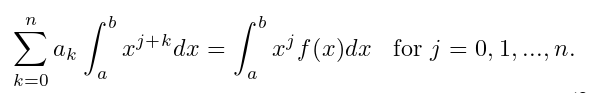

问题是找到使得E最小的a0,…,an 。使得E最小的必要条件是∂E/∂aj = 0,从而给出了法方程:

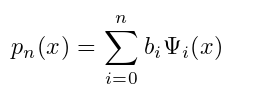

我们现在可以找到该形式的最小二乘多项式逼近:

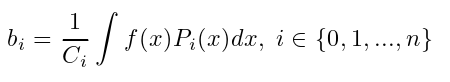

其中{ Ψi } i∈{ 0,1 …,n }是一组正交多项式。勒让德多项式 是关于权函数w ( x ) = 1在区间[ -1 , 1]上的一组正交函数。在这种情况下,最小二乘多项式逼近的系数pn表示如下:

是关于权函数w ( x ) = 1在区间[ -1 , 1]上的一组正交函数。在这种情况下,最小二乘多项式逼近的系数pn表示如下:

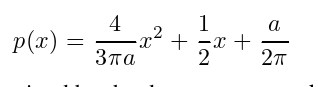

基于这种方法,我们可以用二次多项式近似ReLU函数为:

其中,a由所处理的数据决定。

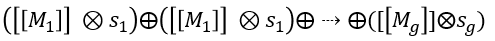

Paillier同态加密

同态加密允许在加密数据上进行安全计算。为了应对深度神经网络(主要是乘法和加法)中的操作,我们采用了一个著名的部分同态加密系统Paillier。Paillier同态加密支持密文之间无限制的加法,以及密文与一个标量常数之间的乘法。给定密文{ [ [ M1 ] ],[ [ M2 ] ],· · ·,[ [ Mg ] ] }和标量常数{ s1,s2,· · ·,sg },可以在不知道明文消息的情况下计算 。其中,[ [ Mg ] ]表示密文,⊕是与密文的同态加法, ⊗是密文与一个标量常数的同态乘法。

。其中,[ [ Mg ] ]表示密文,⊕是与密文的同态加法, ⊗是密文与一个标量常数的同态乘法。

Methodology

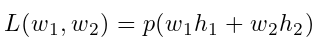

加法同态加密和多项式逼近已被广泛地应用于隐私保护的机器学习中,采用这类逼近在效率和隐私性之间的权衡也得到了深入的讨论。这里我们使用二阶泰勒近似来计算损失和梯度:

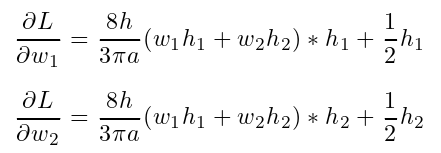

定义: ,然后求导:

,然后求导:

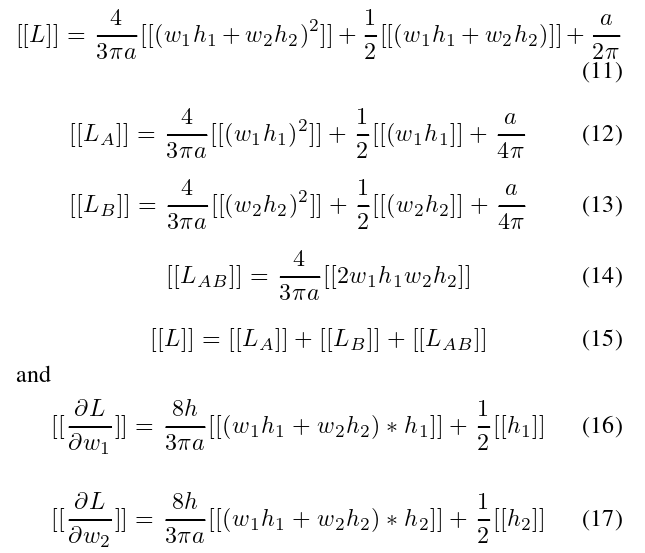

将同态加密应用于L和∂L/∂wi

这里[ [ x ] ]是x的密文。使用二次正交多项式来近似/替换relu激活的原因是为了在同态加密下保持乘法/加法。

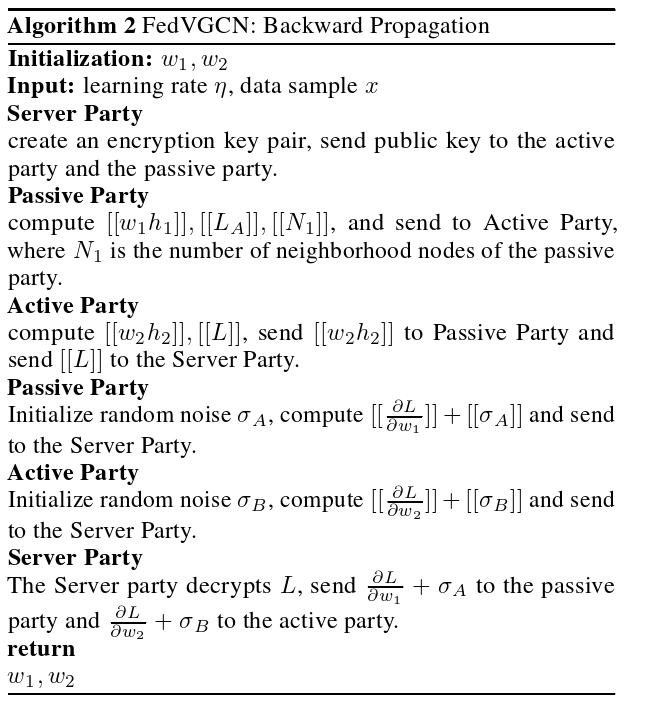

假设企业A和B想要联合训练一个机器学习模型,并且各自的业务系统都有各自的数据。此外,B公司也有模型需要预测的标签数据。我们称A公司为被动方,B公司为主动方。出于数据隐私和安全的考虑,被动方和主动方无法直接交换数据。为了保证数据在训练过程中的机密性,引入了第三方合作者C,称为服务器方。这里我们假设服务者是诚实但好奇的,不与被动方或主动方勾结,但被动方和主动方是诚实但好奇的。被动方信任服务方是一个合理的假设,因为服务方可以由政府等权威机构扮演,也可以由安全的计算节点取代,如英特尔软件保护扩展( SGX )。

无监督损失函数

现有的FL算法主要针对监督学习。为了在完全无监督的情况下学习有用的、预测的表示,我们采用基于图的损失函数鼓励邻近节点具有相似的表示,同时强制不同节点的表示高度不同:

其中v是在固定长度随机走动上共同出现在u附近的节点,σ是sigmoid函数,Pn是负采样分布,Q定义了负样本的个数。

算法

在孤立的GNNs中,节点特征和边都由不同的方持有。垂直数据拆分下的第一步是安全的ID对齐,也称为私有集合交集。也就是说,数据持有者在不暴露彼此不重叠的节点的情况下对其节点进行对齐。在这项工作中,我们假设数据持有者事先已经对齐他们的节点,并准备好进行隐私保护的GNN训练。

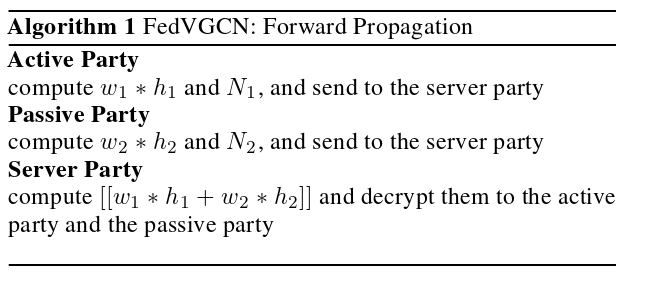

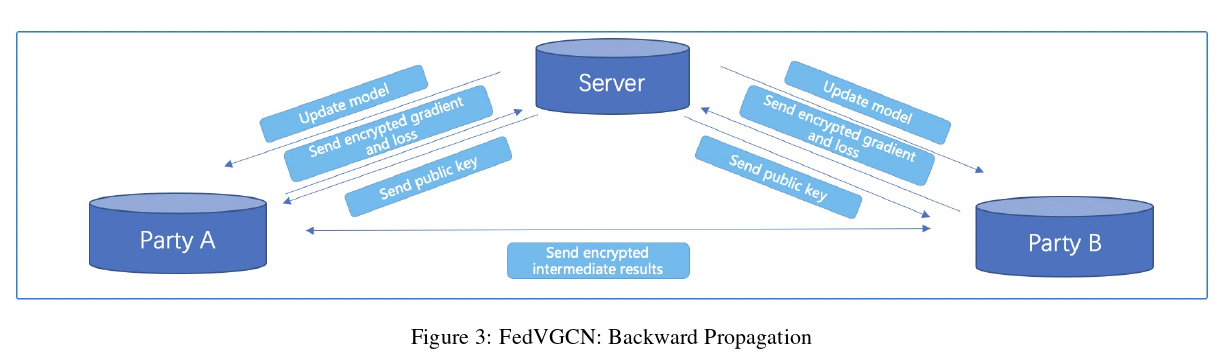

对于GCN,我们提出的纵向联邦算法的前向传播和后向传播分别在算法1和算法2中给出。式中Ni为第i个边的边数。反向传播算法可以用图3来说明。

Conclusion

在这项工作中,我们介绍了一种新的用于图神经网络的纵向联邦学习算法。我们采用加性同态加密来保证隐私性,同时保持准确性。在三个基准数据集上的实验结果表明,我们的算法明显优于在孤立数据上训练的GNN模型,并且与在组合明文数据上训练的传统GNN具有相当的性能。在本文中,我们主要研究了基于GraphSAGE的垂直联邦GNN,未来我们将把我们的方法推广到更复杂的GNN模型,如GAT,GIN等。我们还计划将我们的方法应用到实际的工业应用中。

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结