您现在的位置是:首页 >其他 >DeepSeek R1 本地部署(ollama+open-webui)网站首页其他

DeepSeek R1 本地部署(ollama+open-webui)

deepseek r1本地部署

最近deepseek爆火,但是很多人都发现其服务器繁忙,无法及时的使用,造成糟糕的使用体验,这个服务器繁忙是多方面,这里不做探讨,本文讲解一下如何进行本地部署,以及对电脑的需求。

电脑要求

1.电脑最好有独立显卡,常见的英伟达的显卡,AMD的显卡都可以,显卡的显存越大越好,这里以我使用的8GB的显存为例进行演示,8GB显存可以体验中端的体验,想要高端的体验,得上好的显卡了,例如4090,5090D等,或者去租用云显卡。

2.电脑的内存至少16GB起步,磁盘20GB的空闲空间。

ollama下载

Ollama这是ollama的官网,用任意一个浏览器打开就行。点击下载按钮就行,ollama就可以下载了。

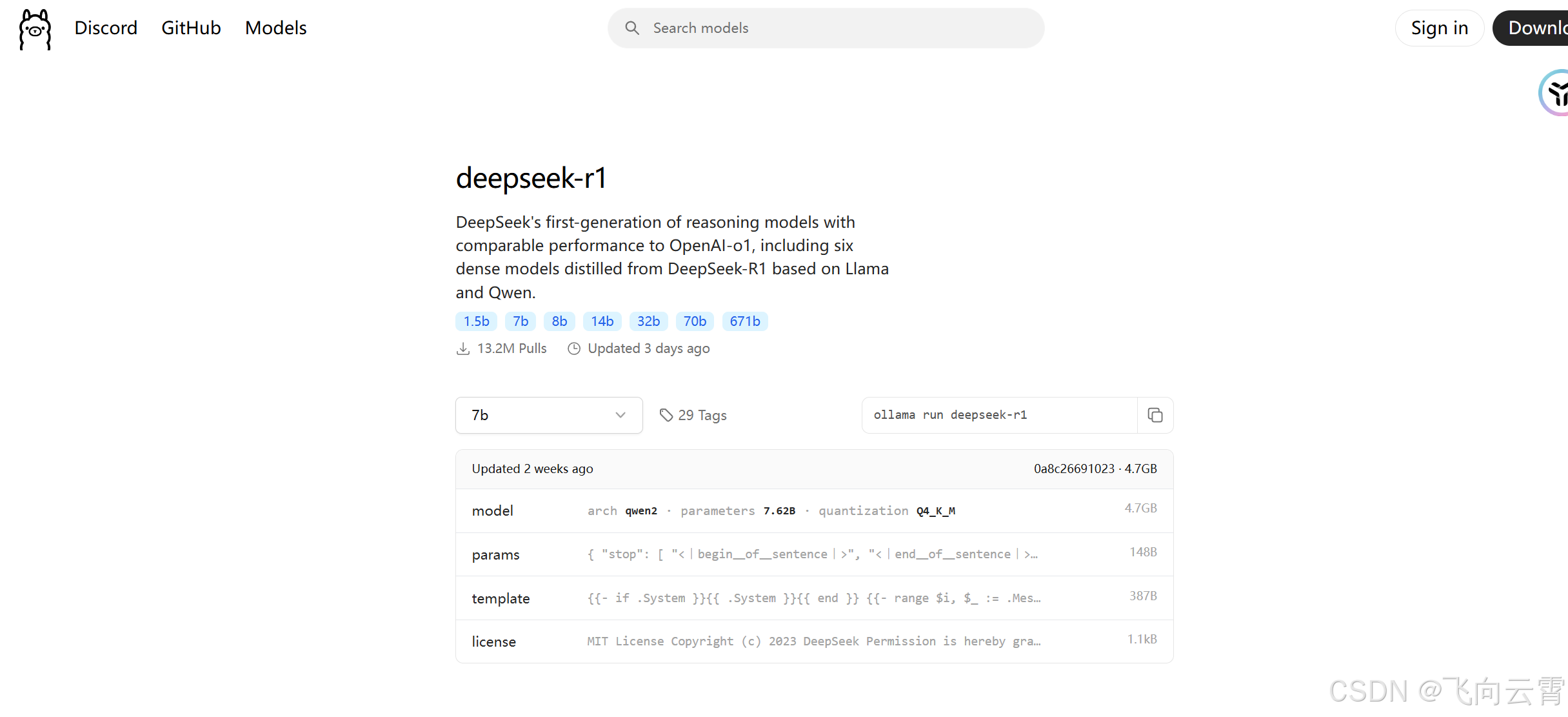

下图就是ollam在上面搜索框,搜索 deepseek-r1的界面。

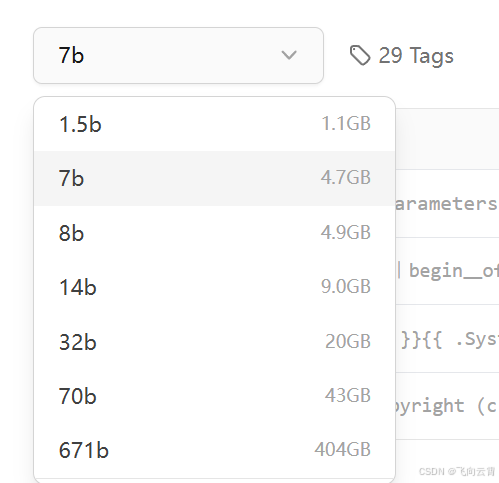

这里有很多的参数可选,b的意思就是10亿,代表模型的大小,肯定是数值越大,模型的表现就越好,我这里是8GB的显存就选择8b就行了。

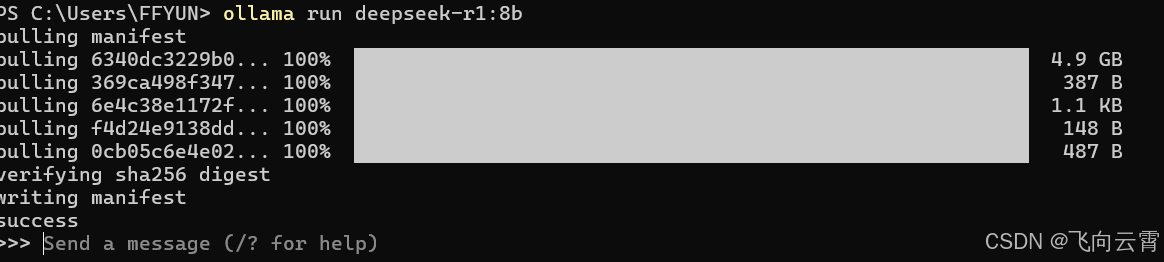

复制这行代码,在命令提示符里粘贴,按回车键运行。(命令提示符可通过win+R,输入cmd打开或者右键微标键点击终端。)

如上图所示,就开始下载模型了。这里就可以使用了,通过命令行的形式与deepseek进行对话。这样的界面不太友好,所以这里推荐使用开源open-webui的界面,加载deepseek,体验会更好一点。

open-webui下载及使用

open-webui/open-webui: User-friendly AI Interface (Supports Ollama, OpenAI API, ...) (github.com)

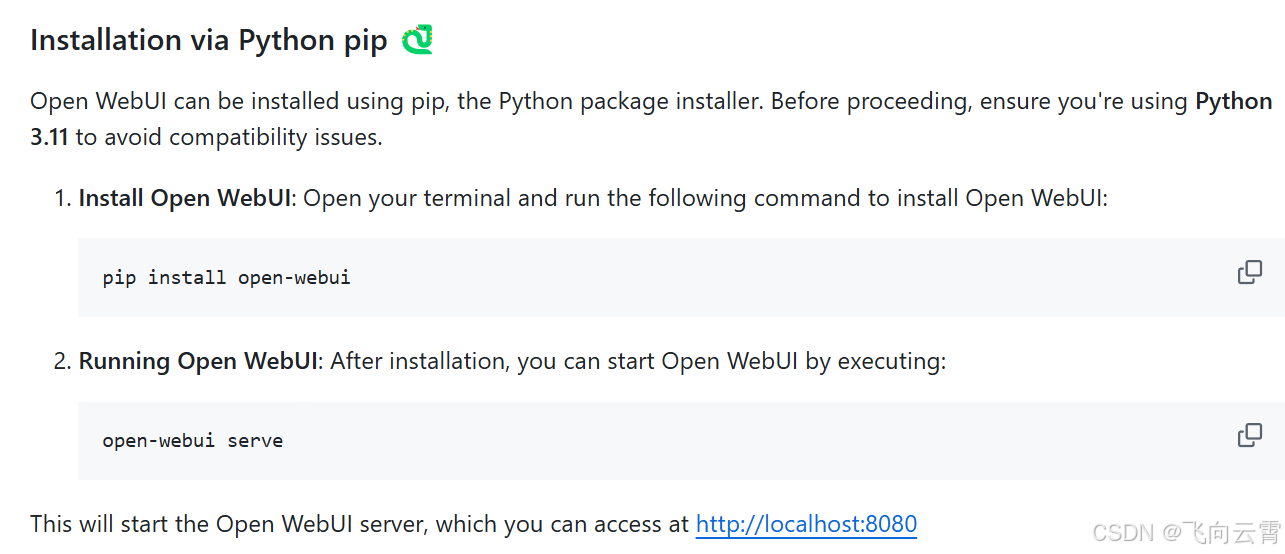

点击上面链接就可以直接进入open-webui的界面了,或者通过github,搜索open-webui,选择第一个star数最多的一个。点击进去之后,往下翻找到下图,这里是如何下载的方法。

、

这里推荐使用conda创建一个虚拟环境,然后再运行上述代码。【anaconda】conda创建、查看、删除虚拟环境(anaconda命令集)_conda 创建环境-CSDN博客

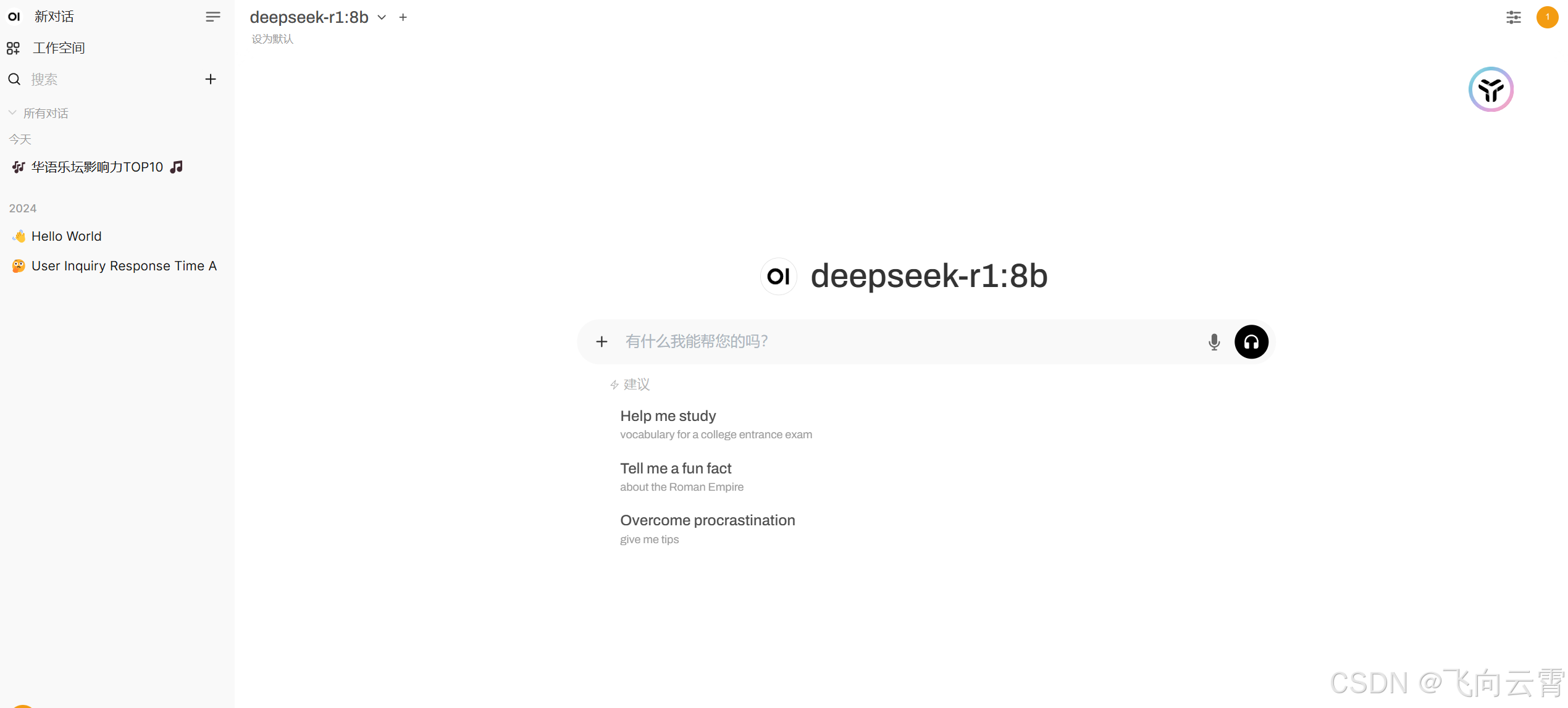

打开之后,界面就如上图,在这里选择左上角,选择模型为deepseek r1,好了现在可以自由的开始与depseek进行对话了。

使用ollama+open-webui还可以使用其他的大模型,qwen等非常多的大模型。大家可以自行体验各家大模型,看其优劣如何。

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结