您现在的位置是:首页 >技术杂谈 >Ollama+OpenWebUI部署本地大模型网站首页技术杂谈

Ollama+OpenWebUI部署本地大模型

简介Ollama+OpenWebUI部署本地大模型

安装ollama

#下载ollama_install.sh并保存

curl -fsSL https://ollama.com/install.sh -o ollama_install.sh

#使用github文件加速替换github下载地址

sed -i 's|https://ollama.com/download/ollama-linux|https://gh.llkk.cc/https://github.com/ollama/ollama/releases/download/v0.5.7/ollama-linux|g' ollama_install.sh

#替换后增加可执行权限

chmod +x ollama_install.sh

#执行sh下载安装

sh ollama_install.sh

vim /etc/systemd/system/ollama.service

最后让配置生效

systemctl daemon-reload

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin"

# 添加环境变量:

Environment="OLLAMA_HOST=0.0.0.0:11434"

[Install]

WantedBy=default.target

vim /etc/profile

最后让配置生效

source /etc/profile

# /etc/profile: system-wide .profile file for the Bourne shell (sh(1))

# and Bourne compatible shells (bash(1), ksh(1), ash(1), ...).

if [ "${PS1-}" ]; then

if [ "${BASH-}" ] && [ "$BASH" != "/bin/sh" ]; then

# The file bash.bashrc already sets the default PS1.

# PS1='h:w$ '

if [ -f /etc/bash.bashrc ]; then

. /etc/bash.bashrc

fi

else

if [ "$(id -u)" -eq 0 ]; then

PS1='# '

else

PS1='$ '

fi

fi

fi

if [ -d /etc/profile.d ]; then

for i in /etc/profile.d/*.sh; do

if [ -r $i ]; then

. $i

fi

done

unset i

fi

# 放行外网使用:

export OLLAMA_HOST=0.0.0.0:11434

启动ollama

# 查看服务是否在运行

systemctl status ollama

# 如果服务已启动,先停止

systemctl stop ollama

# 手动启动服务

ollama serve

#后台运行

nohup ollama serve &

安装Open-WebUI

本地使用 docker 部署Open-WebUI,使用以下命令下载 Open-WebUI

docker pull ghcr.io/open-webui/open-webui:main

启动 Open-WebUI

创建本地目录,避免重启后数据丢失

mkdir /opt/open-webui/data

cd /opt/open-webui/

启动容器

docker run -d -p 3000:8080 -v $PWD/data:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

启动成功后,可在终端中查看容器状态,通过浏览器访问Open-WebUI:http://localhost:3000

配置 Ollama 地址:

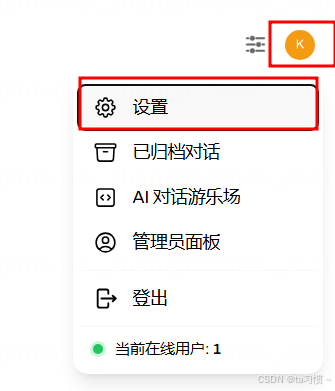

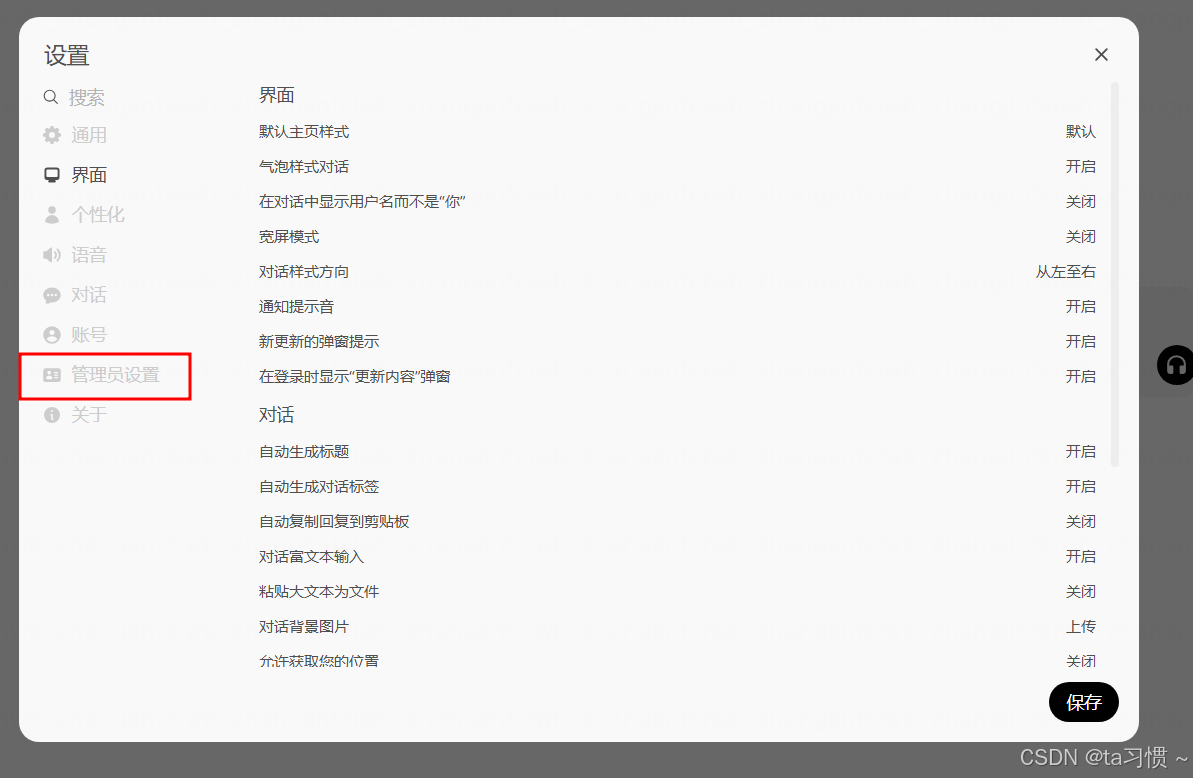

浏览器进入 Open-WebUI 后,点击右上角的设置图标 进入设置页面。在“模型”选项卡中,点击“添加模型”,选择“Ollama”,并输入 Ollama 的地址(默认为http://localhost:11434)。

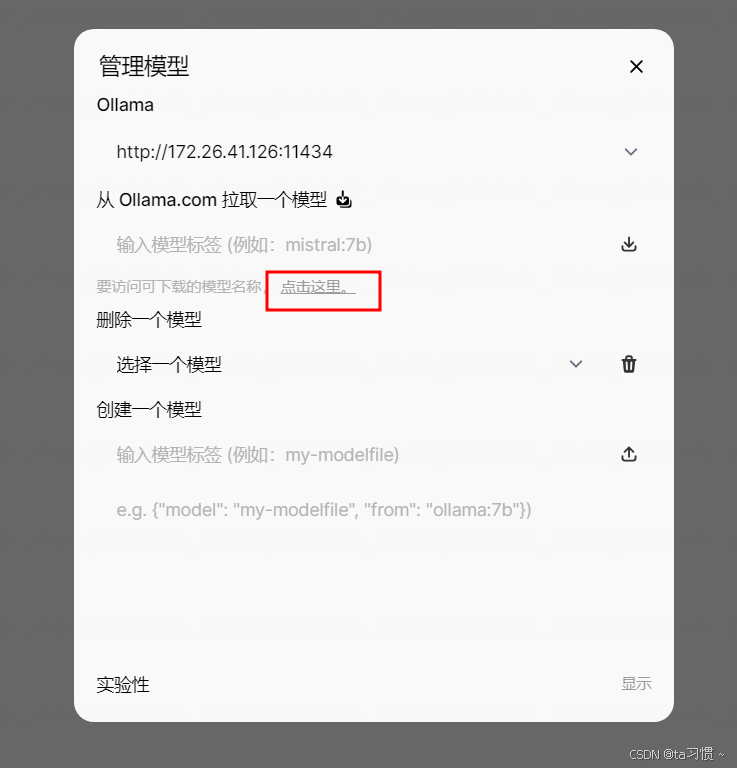

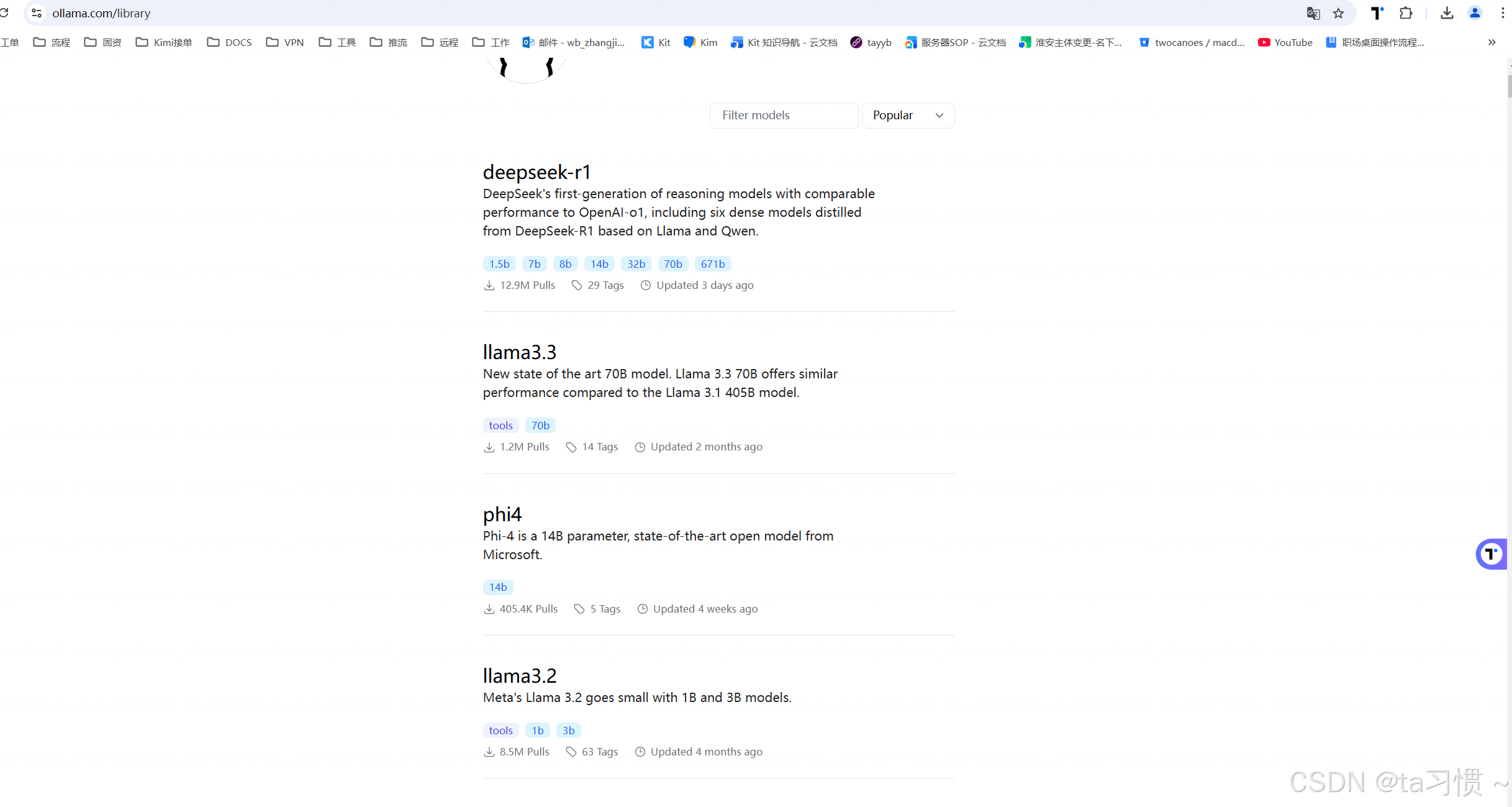

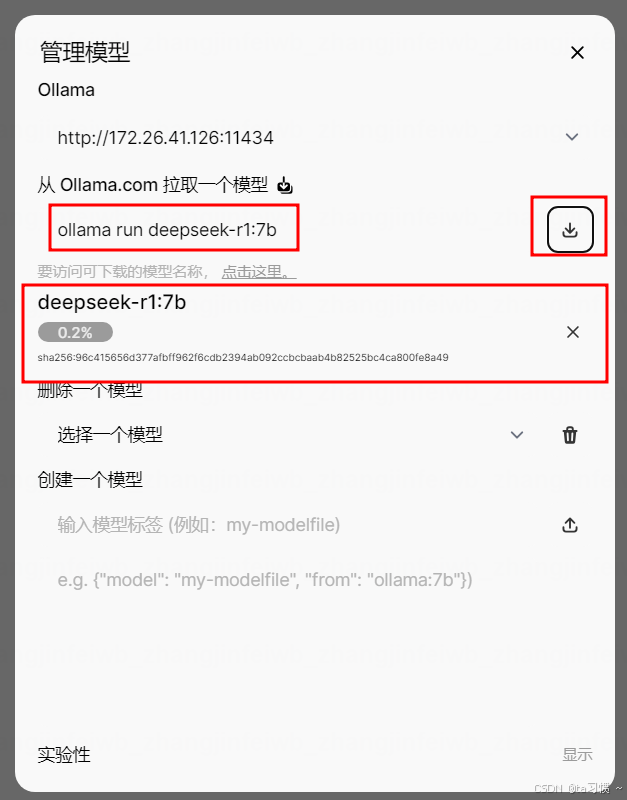

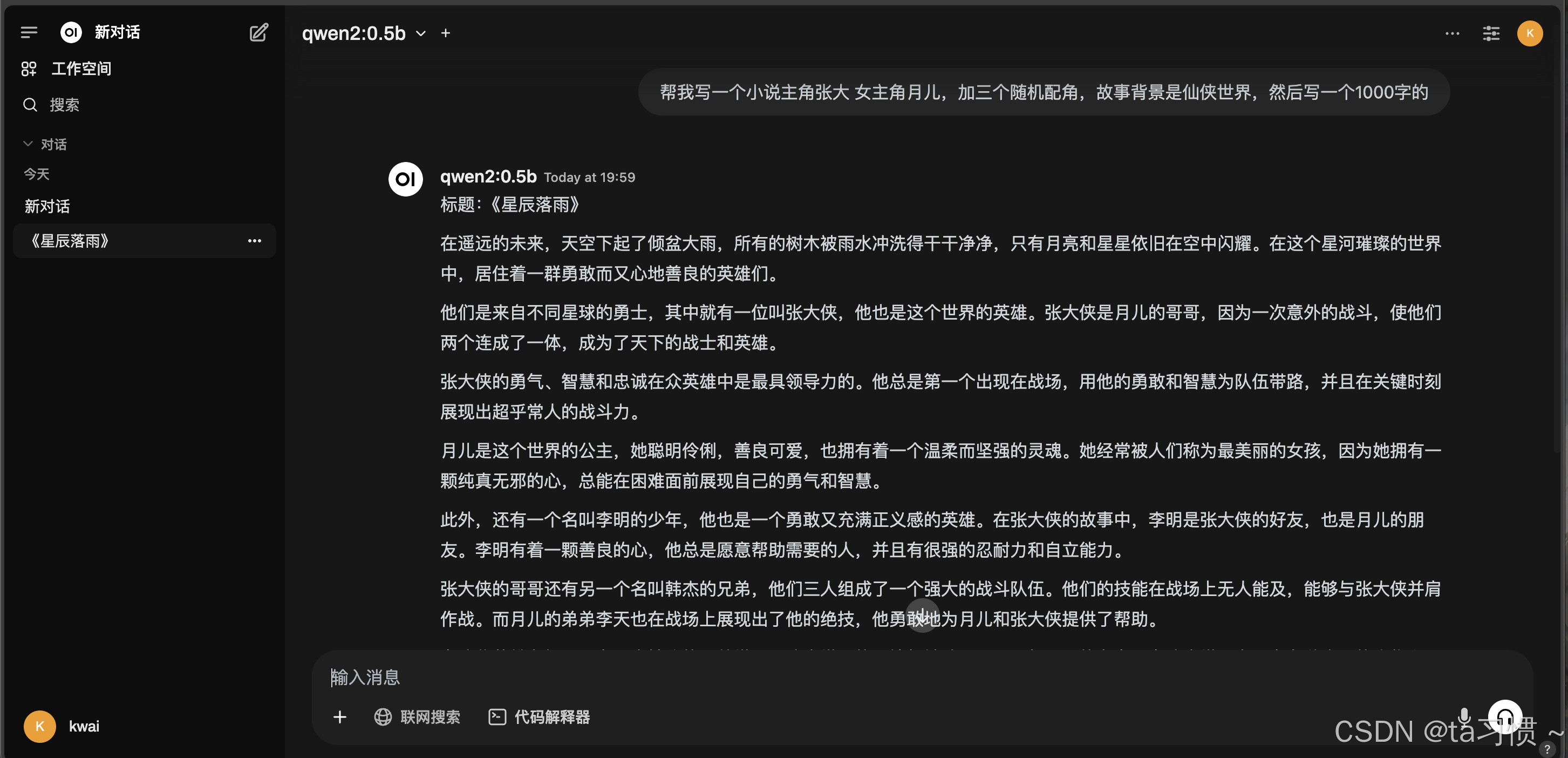

选择一个自己喜欢的大模型

根据自己电脑的配置选择,选择好之后复制

粘贴到这里然后点击下载,等待下载完成就可以了

我这里使用的是啊里开源Qwen2.5 大模型可以多下载几个大模型

风语者!平时喜欢研究各种技术,目前在从事后端开发工作,热爱生活、热爱工作。

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结