您现在的位置是:首页 >其他 >(2023,语义混合)处理神经网络中语义和视觉对齐的差异网站首页其他

(2023,语义混合)处理神经网络中语义和视觉对齐的差异

Addressing Discrepancies in Semantic and Visual Alignment in Neural Networks

公众号:EDPJ

目录

0. 摘要

对于图像分类任务,神经网络主要依赖于视觉模式。 在稳健的网络中,我们期望视觉上相似的类以相似的方式表示。 我们考虑以下问题:何时语义相似的类在视觉上不相似,以及何时在语义不相似的类中存在视觉相似性。 我们提出了一种数据增强技术,其目标是更好地将语义相似的类与任意(非视觉)语义关系对齐。 我们利用最近在基于扩散的语义混合方面的工作来生成两个类的语义混合体,并将这些混合体作为增强数据添加到训练集中。 我们通过评估模型在对抗性扰动数据上的性能来评估该方法是否增加了语义对齐,其想法是对抗应该更容易将一个类切换到一个类似表示的类。 结果表明,在使用我们提出的数据增强方法时,语义相似类的对齐有所增加。

1. 简介

在图像分类的常见任务中,神经网络必须依赖图像中的视觉模式(pattern)。 虽然语义关系通常来自视觉对齐,但视觉和语义并不总是相关的。 例如,在旨在区分儿童安全对象和危险实体的系统中,勺子等无害对象在视觉上可能与刀等危险对象相似,混淆两者可能会产生有害影响。 这个例子突出了神经网络中错误严重性(mistake severity)的概念——分类模型的大多数性能度量平等对待所有错误,但实际上有些错误比其他错误更严重。 尽管视觉上相似,但通常将刀与勺子混淆会导致人们高度不信任用于区分有害物体和安全物体的系统。 为了解决这个问题,我们提出了一种数据增强方法,将先验语义知识整合到训练过程中。 特别是,我们关注语义对齐与视觉相似性不一致的情况,因为这是纯粹的数据驱动学习缺乏对象语义的关键信息的地方; 单独的视觉信息可能无法传达类别关系。

使用这种方法,我们的目标是在缺乏视觉相似性的情况下增加语义相似对象之间的对齐。 为了衡量这一点,我们考虑了在扰动条件下错误严重性的度量,其想法是如果类的表示相似,模型将更有可能将一个类误认为另一个类。

这项工作的贡献如下:

- 我们提出了一种使用基于扩散的语义混合来增加语义相似类之间对齐的数据增强方法

- 我们基于 CIFAR100 构建了一个具有任意类关系的数据集,以在视觉相似性与语义相似性不一致时评估我们的方法

- 我们评估我们的方法在对抗性扰动条件下的错误严重性,并发现我们的数据扩充成功地增加了语义相似类之间的对齐

2. 相关工作

之前的工作考虑了将语义信息纳入训练的方法,例如引入层次损失函数和使用对抗性扰动对齐类。 错误严重性的概念出现在许多这些作品中,作为模型鲁棒性的替代度量,其想法是高度不同的类之间的错误比语义相似的类之间的错误更糟糕。Bertinetto (2020) 等人认为近年来错误严重性指标的改进一直停滞不前,因此应该重新审视该指标。

在 (Bertinetto et al., 2020) 中特别感兴趣的是一个讨论,在该讨论中,Bertinetto 将类关系随机化,使得语义接近度不会反映视觉相似性。 在这种情况下,所考虑的分层方法的性能会下降,这表明层次结构中相关类的视觉相似性对于所提出方法的成功至关重要。Bertinetto 指出,“虽然人们可能希望使用这种方法来强制执行特定于应用程序的关系。 . . ,这样做的有效性可能会受到数据的基本属性的限制”。Abreu (2022) 等人的工作在视觉关系不再支持语义关系时发现了类似的行为。 我们的目标是在我们的数据增强方法中解决这种对视觉相似性的依赖。

此外,之前已有使用扩散模型生成合成训练数据的工作。

- (Azizi et al., 2023) 使用扩散模型为图像分类提供合成数据。

- (He et al., 2022) 探索了在 zero-shot 和 few-shot 设置中,从文本到图像生成模型 GLIDE 的合成数据的使用,也用于模型预训练。他们发现合成数据在这些环境中可能是有益的,并进一步研究了增加数据多样性和减少合成数据生成的数据噪声的策略。

- 与我们的方法类似,(Trabucco 等人,2023) 提出了一种基于扩散的数据增强方法。他们使用扩散模型来增强单个图像以使图像的高级语义属性多样化; 例如,修改卡车正面的外观或背景的风景。 我们的工作不同之处在于,我们应用增强来创建图像的语义混合,而不是使给定类的样本多样化。

在我们的方法中,我们利用训练样本的语义扰动作为整合语义知识的一种方式。 具体来说,我们使用训练样本的语义混合,这是一项最近的任务,旨在混合两个不同的概念以合成一个新概念。 (Liew et al., 2022) 提出了一种称为 MagicMix 的方法,可以基于预训练的文本条件的扩散模型在语义上混合概念。 MagicMix 不需要任何空间掩码或重新训练,这使得它足够轻便,可以在我们的方法中使用。

我们在评估中使用对抗性扰动(adversarial perturbations)来提供有关模型如何对齐类表示的见解。 正如 (Szegedy et al., 2014) 中介绍的那样,对抗性扰动是可以改变模型对图像预测的小扰动。 (Madry et al., 2018) 提供了对抗扰动的优化视图,使我们能够解决 L2 有界投影梯度下降 (PGD) 对手的攻击。

3. 方法

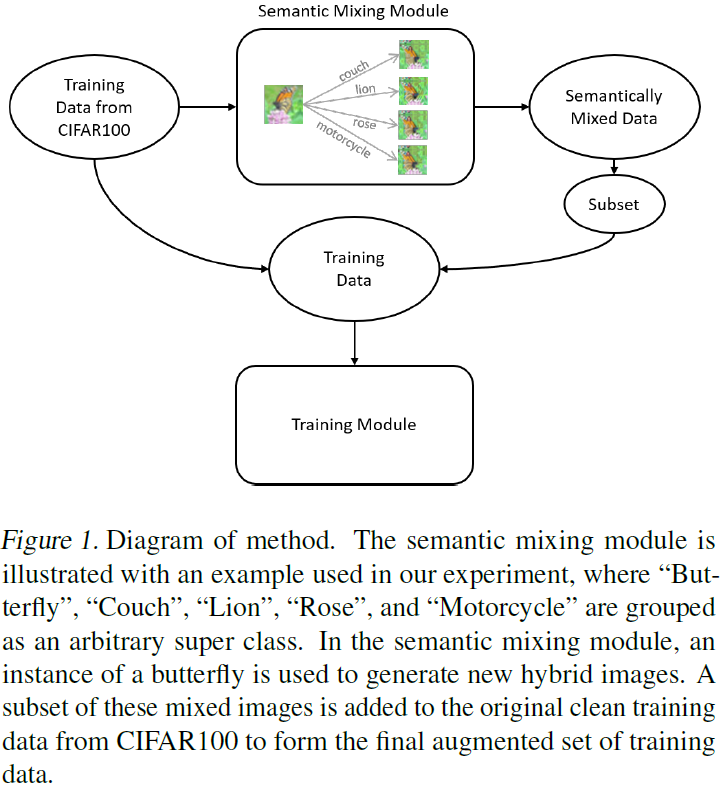

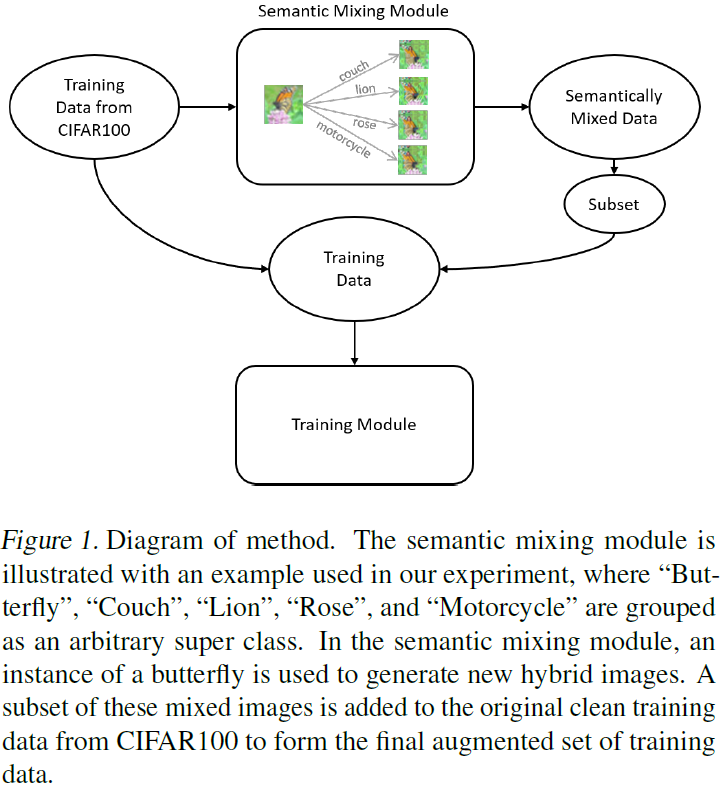

我们通过在训练过程中合并 “语义混合” 数据,将语义知识嵌入到训练过程中。 具体来说,我们提出了一种数据增强技术,其中训练数据用于生成新的训练样本,这些样本是两个语义相似类的混合体。 为了提高效率,我们使用 MagicMix 流程预先生成此数据:对于训练集中的每个图像,我们针对其超类中的每个其他类生成一个新的混合图像(参见图 1)。

我们添加训练中遇到的任何给定实例的类的增强图像的概率,从而改变训练中使用的增强数据量。 鉴于增强数据与干净训练数据的比例很高,这种方法使我们能够防止增强数据完全支配干净数据。 在我们的实验中,我们将“低增强”称为在训练中为任何给定实例添加增强图像的概率为 25%,将“高增强”称为添加增强图像的概率为 50%。 通过随机选择与给定实例具有相同基类的预生成图像来选择增强图像。 增强实例被标记为 50% 作为基类,50% 作为目标类。

4. 实验

以在任意类关系中添加对齐为重点,我们形成了我们的数据集,从而最小化同一超类中类的视觉相似性,并合并不同超类中类的视觉相似性。 作为我们的数据集,我们从 CIFAR100 中选择了五个视觉上不同的超类,并重新分配了类,使得每个原始超类中的一个类在每个新超类中。 我们的超类分组如表 1 所示。我们将原始超类(花、家具、昆虫、食肉动物、车辆)称为视觉超类,将新超类(A、B、C、D、E)称为语义超类以避免两者混淆。

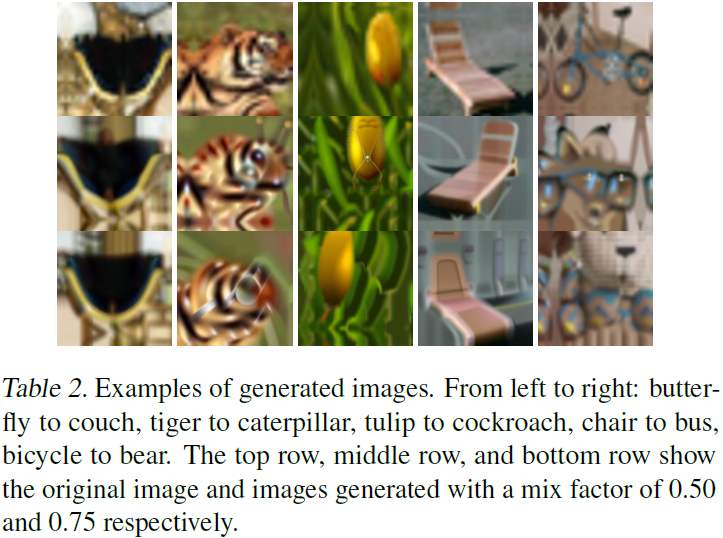

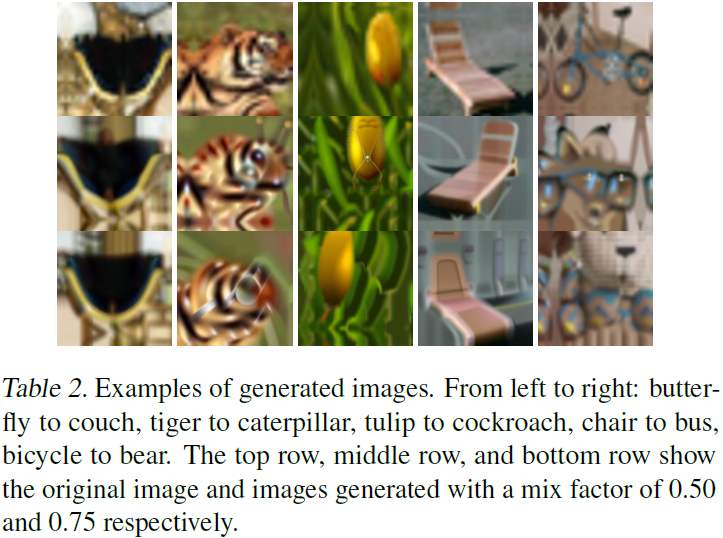

我们使用 MagicMix 流程的图像-文本混合预先生成我们的混合图像。 对于训练集中的每个图像,我们创建了四个混合图像,在同一超类中每个其他精细类创建一个混合图像。 训练集中的图像用作基础图像,MagicMix 模块中的提示(prompt)设置为同一超类中的精细类名称。 MagicMix 模块允许设置 [0, 1] 范围内的混合因子,以定义针对目标提示的混合强度。 我们根据模型改变混合系数 - 对于低混合强度,我们使用 0.50 的混合系数,对于高混合强度,我们使用 0.75 的混合系数。 示例图像如表 2 所示。

我们使用错误的超类准确度指标来评估我们的方法。 特别是,我们研究了严重程度不断增加的对抗性实例的指标,其想法是,如果模型具有视觉上相似类的相似表示,则很容易找到从一个类到超类之外的另一个类的对抗性扰动。

正如 (Madryet al., 2018) 中提出的那样,使用 L2 有界投影梯度下降对抗对对抗性攻击进行建模。 对于在数据分布 D 和损失函数 L 上具有学习参数 θ 的模型 f,我们通过求解下式找到具有标签 y 的给定实例 x 的对抗性扰动 δ

![]()

其中 ε 是对抗的 L2 边界。

我们比较的模型如下:

- 标准模型:在没有额外增强数据的情况下训练的模型

- 低增强,低混合强度:使用 25% 的额外增强数据和 0.5 的混合强度训练模型

- 低增强,高混合强度:使用 25% 的额外增强数据和 0.75 的混合强度训练模型

- 高增强,低混合强度:使用 50% 的额外增强数据和 0.5 的混合强度训练模型

- 高增强、高混合强度:使用 50% 的额外增强数据和 0.75 的混合强度训练模型

5. 结果

在本节中,我们将展示对抗性扰动严重程度增加时,错误严重程度结果。 首先,我们将证明采用我们提出的增强技术的模型在对抗性扰动实例的错误严重性方面表现更好。 我们将另外证明我们的技术减少了视觉相似类中的错误。 这些结果表明我们的方法有助于增加与视觉相似性不一致的语义对齐。

如图 3 所示,与标准模型相比,使用我们的数据增强技术的模型在扰动实例错误方面具有更高的超类准确度。高数据增强、高混合强度模型在该指标上的整体表现最佳,性能接近使用干净数据的标准模型,对于所有非零扰动水平取得最佳性能。 为了解决标准模型和数据增强模型在干净数据上的相似性能,我们假设 CIFAR100 数据集的简单性导致模型在低水平扰动时仅对困难示例(例如,具有独特或误导性特征的示例)犯错误 。 随着扰动级别的增加,模型可能会开始在具有更多标准特征的示例上出错,这解释了以下事实:使用数据增强的模型的更好性能仅出现在更高扰动的数据上。

使用数据增强技术的模型在同一视觉超类(例如“Flowers”)中的类之间的错误百分比也较低(如图 3 所示)。 这表明该模型在视觉上相似的类之间学习到较低的相关性,这些类在语义上不相似。

最后,我们在图 4 中显示了整体模型准确性和语义超类准确性。使用数据增强技术的模型在所有非零水平的对抗性扰动上都改进了这两个指标,并且高增强、高混合强度模型还改进了干净精度和超类精度。 由于数据集不是很有挑战性,即使是使用数据增强的最佳性能模型的改进在干净精度和超类精度方面也是微不足道的。当数据集随着扰动的增加而变得更具挑战性,我们的方法提高了性能,因为 MagicMix 失真有助于将类的特征分组在同一语义超类中。 即使在最高级别的扰动下,在具有数据增强的模型中也会保持一些语义对齐。

6. 讨论与结论

对于使用数据增强来增加具有任意视觉关系的类之间的语义对齐,我们的研究结果提供了有希望的初步结果。 更一般地说,这一发现表明合成数据有可能将先验知识注入训练。 作为未来的工作,我们希望将我们的方法应用于更复杂的数据集,其中模型更有可能看到模棱两可的图像或难以分类的图像。 此外,该方法可以扩展到需要结合特定领域知识而不是任意类关系的应用。

参考

Abreu N, Vaska N, Helus V. Addressing Discrepancies in Semantic and Visual Alignment in Neural Networks[J]. arXiv preprint arXiv:2306.01148, 2023.

S. 总结

S.1 主要思想

作者使用基于 diffusion 的数据增强来增加具有视觉关系的类别的语义对齐,从而提升模型对抗扰动的稳健性。

S.2 语义混合

基于 diffusion 的数据增强 MagicMix 对图像进行语义混合,流程如图 1 所示。语义混合的结果如图 2 所示。以第 4 列(椅子到公交车)为例,随着语义混合程度的加深(0% → 50% → 75%),椅子的外观表现得越来越像公交车。

S.3 方法

使用纯净数据 + 语义混合数据训练模型,使模型在有扰动的情况下,依然能够进行准确的分类,即,提升了模型的稳健性。

U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结