您现在的位置是:首页 >技术教程 >LVS负载均衡群集网站首页技术教程

LVS负载均衡群集

LVS负载均衡群集

一、企业群集应用概述

1.1 群集的发展

- 在各种互联网应用中,随着站点对硬件性能、响应速度、服务稳定性、数据可靠性等要求越来越高,单台服务器将难以承担所有的访问。为了满足生产需求,有了横向和纵向扩张。

- 纵向扩展:使用价格昂贵的大型机、专用负载分流设备等。

- 横向扩展:构建群集服务器——通过整个多台相对廉价的普通服务器,以同一个地址提供相同的服务。

- 在Linux系统中,有一种非常常用的群集技术——LVS(Linux Virtual Server,Linux虚拟服务器)。

1.2 群集的含义

- Cluster,集群、群集,表示一群、一串的意思,用在服务器领域则表示大量服务器的集合体,以区分于单个服务器。

- 由多台主机构成,但对外只表现为一个整体,只提供一个访问入口(域名或IP地址),相当于一台大型计算机。

特点:多台主机,干同一件事,展现为一个整体

二、企业群集分类

2.1 针对目标分类

1、负载均衡群集

2、高可用群集

3、高性能运算群集

2.1.1 负载均衡群集 (Load Balance Cluster)

1、提高应用系统的响应能力、尽可能处理更多的访问请求减少延迟为目标,获得高并发、高负载(LB)的整体性能

2、LB的负载分配依赖于主节点的分流算法,将来自客户机的访问请求分担给多个服务器节点,从而缓解整个系统的负载压力。例如,“DNS轮询” “反向代理”等

2.1.2 高可用群集 (High Availability Cluster)

1、提高应用系统的可靠性、尽可能地减少中断时间为目标,确保服务的连续性,达到高可用(HA)的容错效果

2、HA的工作方式包括双工和主从两种模式,双工即所有节点同时在线主从则只有主节点在线,但当出现故障时从节点能自动切换为主节点例如,“故障切换””“双机热备”等

2.1.3 高性能运算群集 (High Performance Computer Cluster)

1、以提高应用系统的CPU运算速度、扩展硬件资源和分析能力为目标,获得相当于大型、超级计算机的高性能运算(HPC)能力

2、高性能依赖于“分布式运算”、“并行计算”,通过专用硬件和软件将多个服务器的CPU、内存等资源整合在一起,实现只有大型、超级计算机才具备的计算能力。例如,“云计算”“网格计算”等

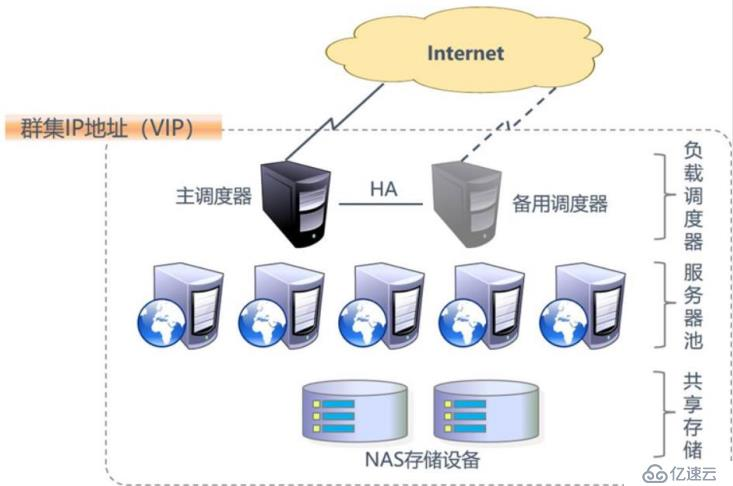

三、负载均衡群集架构

3.1 负均衡的结构

- 第一层:负载调度器(Load Balancer或Director)

- 对外使用所有服务器共有的VIP地址,也称为群集访问整个群集系统的唯一入口,IP 地址。通常会配置主、备两台调度器实现热备份,当主调度器失效以后能够平滑替换至备用调度器,确保高可用性。

- 第二层:服务器池 (Server Pool)

- 群集所提供的应用服务、由服务器池承担,其中每个节点具有独立的RIP地址(真实IP),只处理调度器分发过来的客户机请求。当某个节点暂时失效时,负载调度器的容错机制会将其隔离,等待错误排除以后再重新纳入服务器池。

- 第三层:共享存储 (Share Storage)

- 为服务器池中的所有节点提供稳定、一致的文件存取服务,确保整个群集的统一性

3.2 负载均衡群集工作模式分析

- 负载均衡群集是目前企业用得最多的群集类型

- 群集的负载调度技术有三种工作模式

1、地址转换(NAT模式)

2、IP隧道(Tun模式)

3、直接路由(DR模式)

3.2.1 NAT模式

1、Network Address Translation ,简称NAT模式

2、类似于防火墙的私有网络结构,负载调度器作为所有服务器节点的网关,即作为客户机的访问入口,也是各节点回应客户机的访问出口

3、服务器节点使用私有IP地址,与负载调度器位于同一个物理网络,安全性要优于其他两种方式

3.2.2 Tun模式

1、IP Tunnel,简称TUN模式

2、采用开放式的网络结构,负载调度器仅作为客户机的访问入口,各节点通过各自的Internet连接直接回应客户机,而不再经过负载调度器

3、服务器节点分散在互联网中的不同位置具有独立的公网IP地址,通过专用IP隧道与负载调度器相互通信

3.2.3 DR模式

1、Direct Routing,简称DR模式

2、采用半开放式的网络结构,与TUN模式的结构类似,但各节点并不是分散在各地,而是与调度器位于同一个物理网络

3、负载调度器与各节点服务器通过本地网络连接,不需要建立专用的IP隧道

四、关于LVS虚拟服务器

4.1 Linux Virtual Server

- 针对Linux内核开发的负载均衡解决方案

- 官方网站: http://www.linuxvirtualserver.org/

- LVS实际上相当于基于IP地址的虚拟化应用,为基于IP地址和内容请求分发的负载均衡提出了一种高效的解决方法

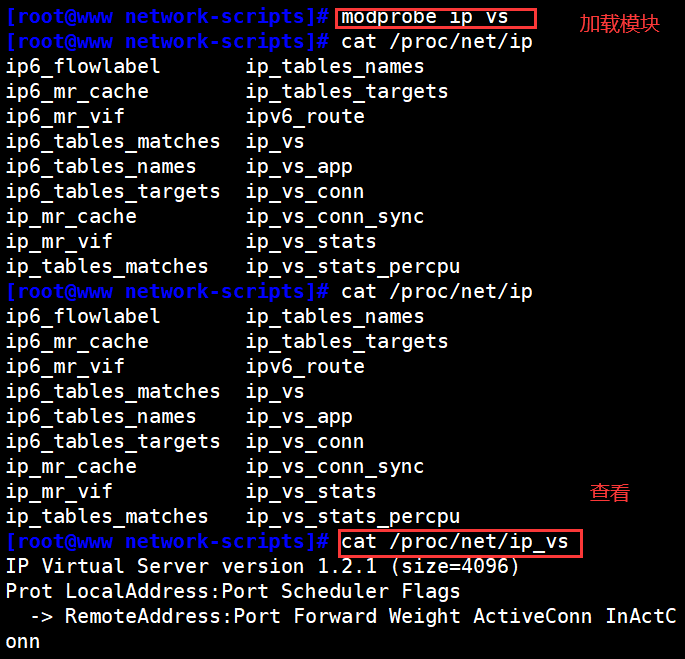

- LVS现在已成为 Linux 内核的一部分,默认编译为 ip_vs 模块必要时能够自动调用。在 CentOS 7 系统中,以下操作可以手动加载ip_vs 模块,并查看当前系统中ip_vs 模块的版本信息。

[root@localhost ~]# modprobe ip_vs #加载IP_vs模块

[root@localhost ~]# cat /proc/net/ip_vs #查看IP_vs版本信息

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

4.2 LVS的负载调度算法

4.2.1 固态调度算法

- 轮询 (Round Robin):轮询算法将请求依次分配给不同的RS节点,即RS节点中均摊分配。适合于RS所有节点处理性能接近的情况

- 加权轮询 (Weighted Round Robin):加权轮训调度,依据不同RS的权值分配任务。权值较高的RS将优先获得任务,并且分配到的连接数将比权值低的RS更多。相同权值的RS得到相同数目的连接数

- 目的地址哈希调度 (destination hashing): 以目的地址为关键字查找一个静态hash表来获得所需RS

- 源地址哈希调度 (source hashing) :以源地址为关键字查找一个静态hash表来获得需要的RS

4.2.2 动态调度算法

- 加权最小连接数算法(Weighted Least-Connection Scheduling):假设各台RS的权值依次为四,当前tco连接数依次为T,依次去/m为最小的RS作为下一个分配的RS

- 最小连接数调度(least-connection):IPVS表存储了所有活动的连接。LB会比较将连接请求发送到当前连接最少的RS

- 基于地址的最小连接数调度 (locality-based1east-coect1):将来自同一个目的地的请求分配给同一台RS,此时这台服务器是尚未满负荷的。否则就将这个请求分配给连接数最小的RS,并以它作为下一次分配的首先考虑

4.3 LVS群集创建与管理

- ipvsadm 是在负载调度器上使用的LVS群集管理工具,通过调用ip_vs模块来添加、删除服务器节点,以及查看群集的运行状态。

- 在CentOS 7系统默认没有安装,需要自行安装。

[root@localhost ~]# yum -y install ipvsadm

[root@localhost ~]# ipvsadm -v

ipvsadm v1.27 2008/5/15 (compiled with popt and IPVS v1.2.1)

- ipvsadm命令

| 命令 | 说明 |

|---|---|

| -A | 添加虚拟服务器 |

| -D | 删除整个虚拟服务器 |

| -s | 指定负载调度算法(轮询:rr、加权轮询:wrr、最少连接:lc、加权最少连接:wlc) |

| -a | 表示添加真实服务器(节点服务器) |

| -d | 删除某一个节点 |

| -t | 指定 VIP地址及 TCP端口 |

| -r | 指定 RIP地址及 TCP端口 |

| -m | 表示使用 NAT群集模式 |

| -g | 表示使用 DR模式 |

| -i | 表示使用 TUN模式 |

| -w | 设置权重(权重为 0 时表示暂停节点) |

| -p 60 | 表示保持长连接60秒(默认关闭连接保持) |

| -l | 列表查看 LVS 虚拟服务器(默认为查看所有) |

| -n | 以数字形式显示地址、端口等信息,常与“-l”选项组合使用。ipvsadm -ln |

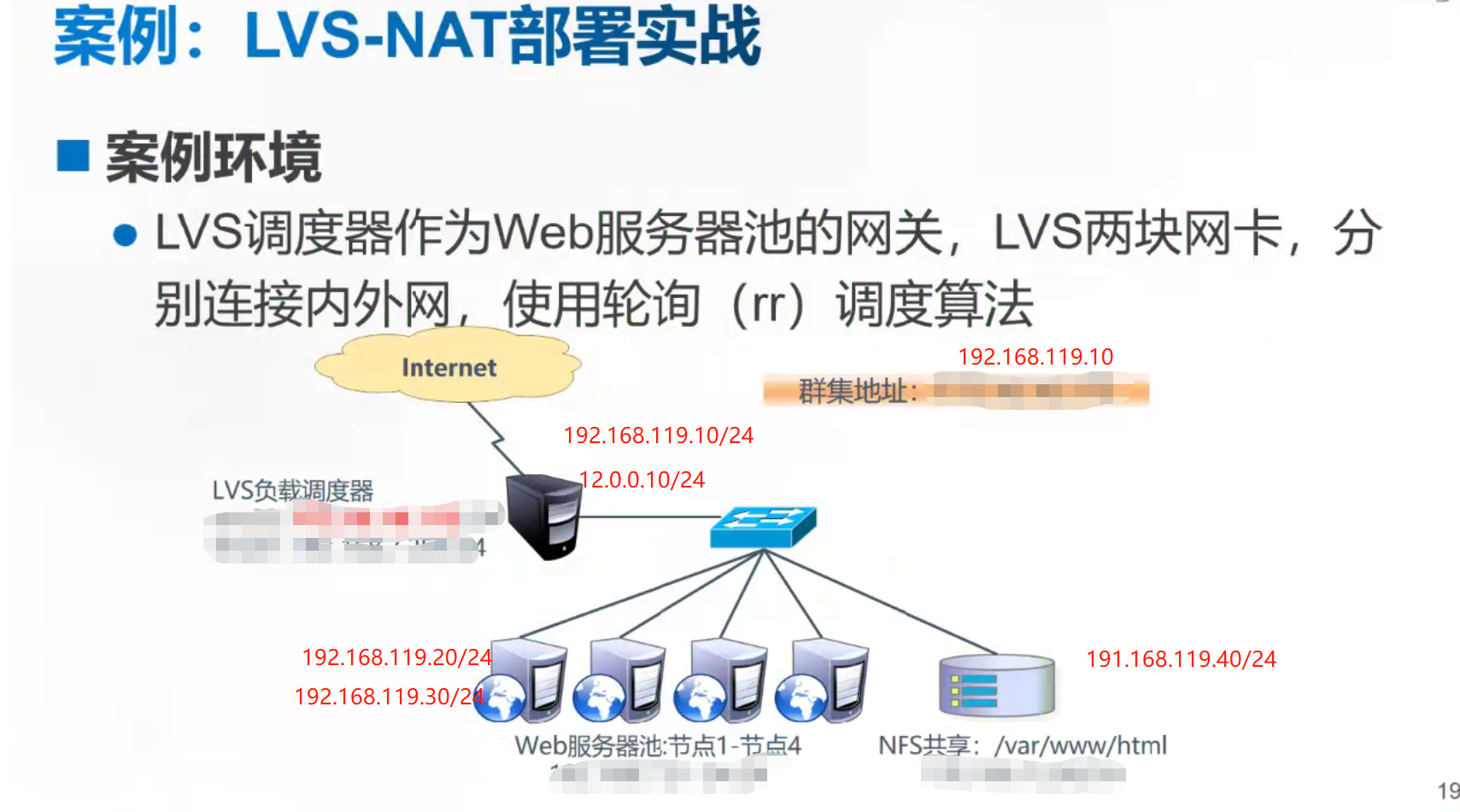

五、LVS-NAT部署实战

5.1 NAT模式 LVS负载均衡群集部署

#环境准备

负载调度器:内网关 ens33:192.168.119.10,外网关 ens35:12.0.0.10

Web节点服务器1:192.168.119.20

Web节点服务器2:192.168.119.30

NFS服务器:192.168.119.40

客户端:12.0.0.12

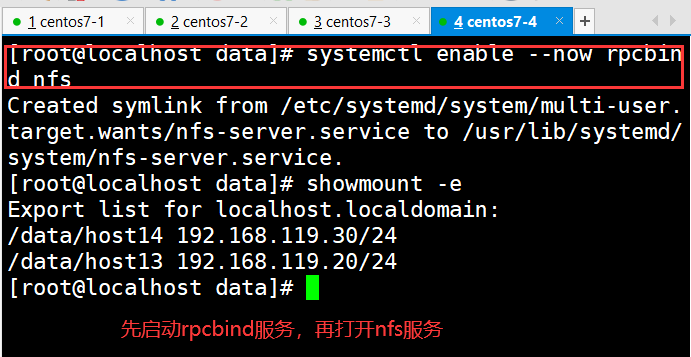

1.部署共享存储(NFS服务器:192.168.119.40)

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

yum install nfs-utils rpcbind -y

systemctl start rpcbind.service

systemctl start nfs.service

systemctl enable nfs.service

systemctl enable rpcbind.service

mkdir -p /data/host13

mkdir -p /data/host14

cd /data/

ls

host13 host14

echo '<h1>This is test 13!</h1>' > host13/index.html

echo '<h1>This is test 14!</h1>' > host14/index.html

vim /etc/exports

/data/host13 192.168.119.20/24(ro)

/data/host14 192.168.119.30/24(ro)

showmount -e

systemctl enable --now rpcbind nfs

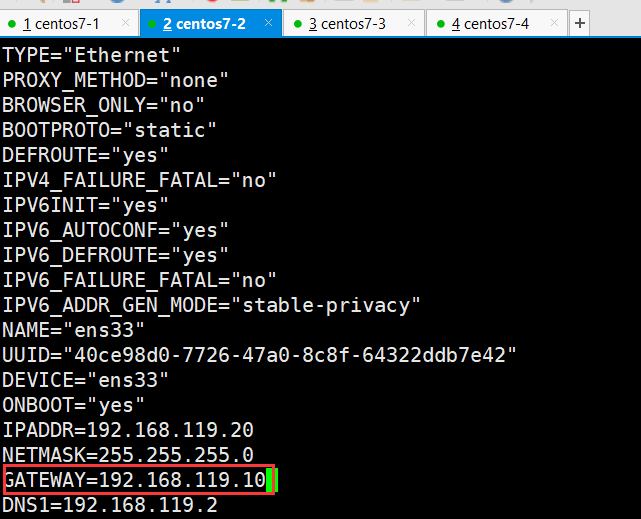

#RS(节点服务器):192.168.119.20

vim /etc/sysconfig/network-scripts/ifcfg-ens33

...

GATEWAY=192.168.119.10

...

systemctl restart network

showmount -e 192.168.119.40

Export list for 192.168.119.40:

/data/host14 192.168.119.30/24.

/data/host13 192.168.119.20/24

mount 192.168.119.40:/data/host13 /usr/local/nginx/html

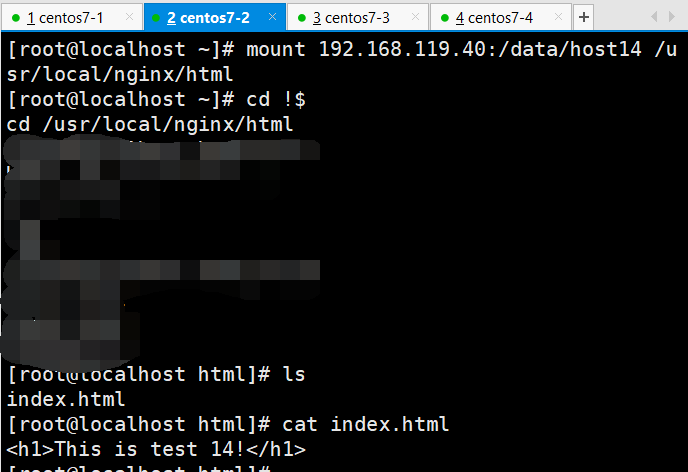

#RS(节点服务器):192.168.119.30

vim /etc/sysconfig/network-scripts/ifcfg-ens33

...

GATEWAY=192.168.119.10

...

mount 192.168.119.40:/data/host14 /usr/local/nginx/html

#测试nfs

打开浏览器访问http://192.168.119.20 http://192.168.119.30

#配置调度器

cd /etc/sysconfig/network-scripts

cp ifcfg-ens33 ifcfg-ens35

vim ifcfg-ens33

#删除网关跟DNS

vim ifcfg-ens35

#删除网关跟DNS

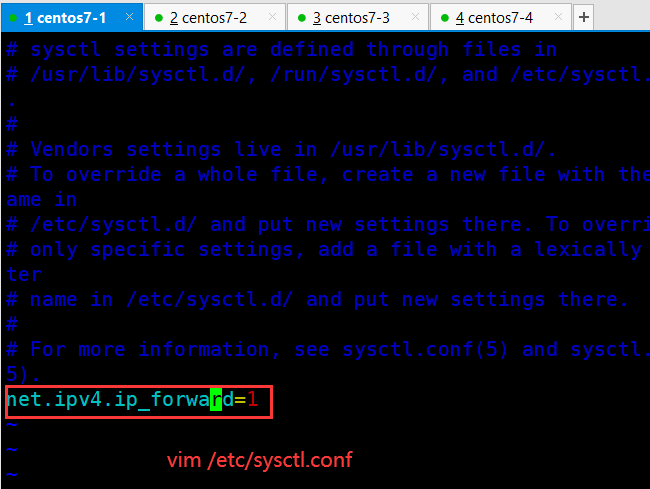

vim /etc/sysctl.conf

...

net.ipv4.ip_forward=1 #添加路由转发

sysctl -p #加载

net.ipv4.ip_forward = 1

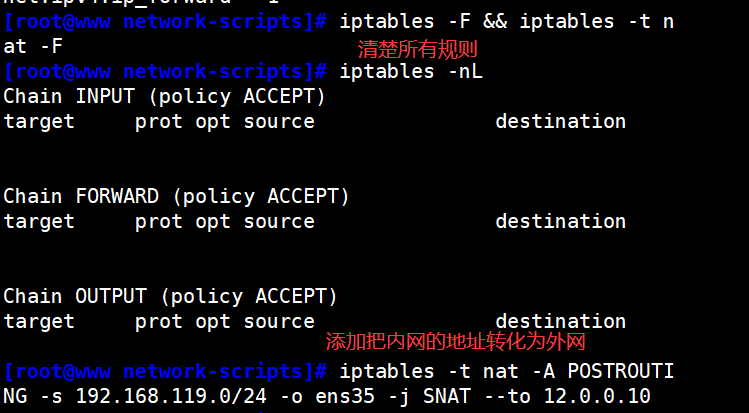

iptables -F && iptables -t nat -F

iptables -t nat -Q POSTROUTING -s 192.168.119.0/24 -o ens35 -j SNAT --to 12.0.0.10

modprobe ip_vs

cat /proc/net/ip_vs

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

yum install -y ipvsadm

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm

ipvsadm -C

ipvsadm -A -t 12.0.0.10:80 -s rr

ipvsadm -a -t 12.0.0.10:80 -r 192.168.119.20 -m -w 1

ipvsadm -a -t 12.0.0.10:80 -r 192.168.119.30 -m -w 1

ipvsadm

vim /usr/local/nginx/conf/nginx.conf,把两台节点服务器的keep_alive长连接设置为0,然后重启nginx服务,方便测试

#测试Client主机访问调度器

#浏览器访问http://12.0.0.10,刷新会在两个分享目录之间来回跳

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结