您现在的位置是:首页 >其他 >KG-BERT: BERT for Knowledge Graph Completion 2019ACL网站首页其他

KG-BERT: BERT for Knowledge Graph Completion 2019ACL

简介KG-BERT: BERT for Knowledge Graph Completion 2019ACL

把BERT用在知识图谱补全上

提出KG-BERT模型,在预训练好的BERT基础上继续fine-tuning。

1.传统KGC方法

传统的KGC方法一般依赖于KGE,而KGE往往通过将KG中的三元组关系投影到某个表示空间中,然后使用打分函数对三元组的合理性进行评估,在用基于正负样本的对比进行模型的训练,而这个表示空间往往和某些数学结构联系在一起,比如最著名的TransE就是向量的加法,RotatE对应了复平面上的旋转,后面还发展出了双曲面、圆锥等各种各样的表示模型。

2.KG-BERT模型

具体的做法就是修改了BERT模型的输入使其适用于知识库三元组的形式。

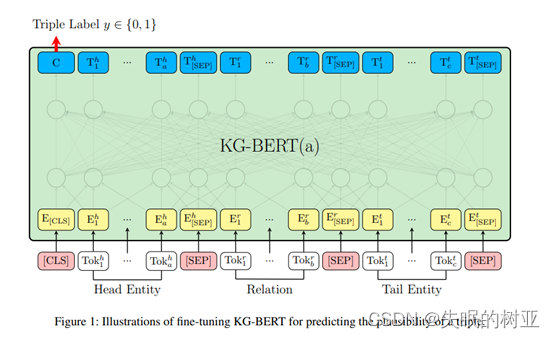

KG-BERT则直接使用BERT模型对三元组进行打分,它将三元组中的头尾实体和关系转换成对应的文本输入([CLS]head[SEP]relation[SEP]tail[SEP])到BERT模型中,然后使用BERT函数输出结果中的CLS标签作为整个三元组的表示向量,并投影到一个打分函数空间中,然后通过三元组分类这样的任务来对BERT进行微调。

3.三元组分类

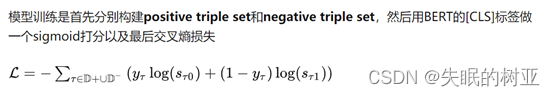

KG-BERT(a)

将三元组转换为文本序列模式,将实体、关系的名称或描述文本,通过[CLS]和[SEP]进行顺序拼接,喂入KG-BERT中后,获得[CLS]的表征向量,并进行二分类,判断该三元组是否成立。

正样本(三元组即在KG中)和负样本(给定一个三元组,随机替换实体或关系,且确保生成的新的三元组在KG中不存在)

4.关系分类

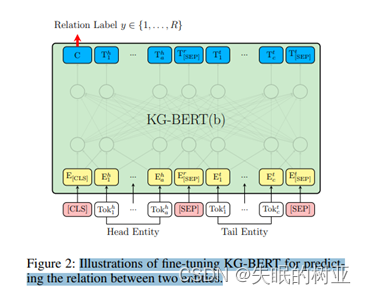

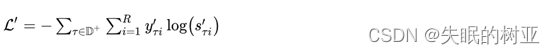

(KG-BERT-b)

KG-BERT也可以完成关系分类,输入两个实体或实体描述,输出多类分类。

这里只是把sigmoid的二分类改成了softmax的关系多分类。

风语者!平时喜欢研究各种技术,目前在从事后端开发工作,热爱生活、热爱工作。

U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结