您现在的位置是:首页 >其他 >回归预测 | MATLAB实现SSA-CNN-LSTM麻雀算法优化卷积长短期记忆神经网络多输入单输出回归预测网站首页其他

回归预测 | MATLAB实现SSA-CNN-LSTM麻雀算法优化卷积长短期记忆神经网络多输入单输出回归预测

回归预测 | MATLAB实现SSA-CNN-LSTM麻雀算法优化卷积长短期记忆神经网络多输入单输出回归预测

预测效果

基本介绍

MATLAB实现SSA-CNN-LSTM麻雀算法优化卷积长短期记忆神经网络多输入单输出回归预测,运行环境Matlab2020b及以上。优化正则化率、学习率、隐藏层单元数。

1.Matlab实现SSA-CNN-LSTM麻雀算法优化卷积长短期记忆网络(CNN-LSTM)多输入单输出回归预测

2.输入多个特征,输出单个变量,多输入单输出回归预测;

3.多指标评价,评价指标包括:R2、MAE、MSE、RMSE等,代码质量极高;

4.麻雀算法优化参数为:学习率,隐含层节点,正则化参数;

5.excel数据,方便替换,运行环境2020及以上。

模型描述

麻雀搜索算法是一种群智能优化算法,在麻雀觅食的过程中,分为发现者和加入者,发现者在种群中负责寻找食物并为整个麻雀种群提供觅食区域和方向,而加入者则是利用发现者来获取食物。为了获得食物,麻雀通常可以采用发现者和加入者这两种行为策略进行觅食。种群中的个体会监视群体中其它个体的行为,并且该种群中的攻击者会与高摄取量的同伴争夺食物资源,以提高自己的捕食率。此外,当麻雀种群受到捕食者的攻击时会做出反捕食行为。

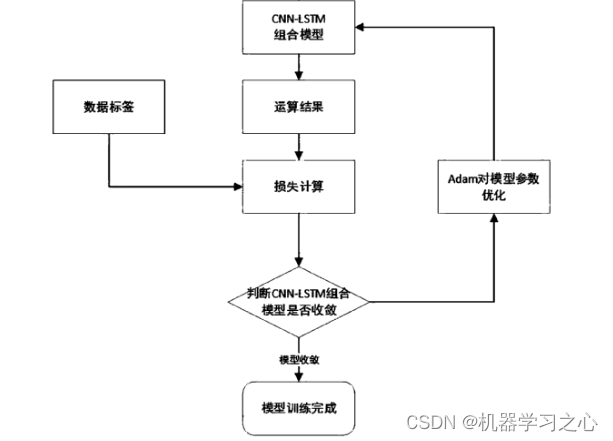

基于卷积神经网络和长短期记忆(LSTM)神经网络的深度学习网络结构。采用特征融合的方法,通过卷积网络提取出浅层特征与深层特征并进行联接,对特征通过卷积进行融合,将获得的矢量信息输入LSTM单元。

程序设计

- 完整源码和数据获取方式1:私信博主,同等价值程序兑换;

- 完整源码和数据下载方式2(资源处直接下载):MATLAB实现SSA-CNN-LSTM麻雀算法优化卷积长短期记忆神经网络多输入单输出回归预测

- 完整程序和数据下载方式3(订阅《组合优化》专栏,同时获取《组合优化》专栏收录的任意8份程序,数据订阅后私信我获取):MATLAB实现SSA-CNN-LSTM麻雀算法优化卷积长短期记忆神经网络多输入单输出回归预测

%% 获取最优种群

for j = 1 : SearchAgents

if(fitness_new(j) < GBestF)

GBestF = fitness_new(j);

GBestX = X_new(j, :);

end

end

%% 更新种群和适应度值

pop_new = X_new;

fitness = fitness_new;

%% 更新种群

[fitness, index] = sort(fitness);

for j = 1 : SearchAgents

pop_new(j, :) = pop_new(index(j), :);

end

%% 得到优化曲线

curve(i) = GBestF;

avcurve(i) = sum(curve) / length(curve);

end

%% 得到最优值

Best_pos = GBestX;

Best_score = curve(end);

%% 得到最优参数

NumOfUnits =abs(round( Best_pos(1,3))); % 最佳神经元个数

InitialLearnRate = Best_pos(1,2) ;% 最佳初始学习率

L2Regularization = Best_pos(1,1); % 最佳L2正则化系数

%

inputSize = k;

outputSize = 1; %数据输出y的维度

% 参数设置

opts = trainingOptions('adam', ... % 优化算法Adam

'MaxEpochs', 20, ... % 最大训练次数

'GradientThreshold', 1, ... % 梯度阈值

'InitialLearnRate', InitialLearnRate, ... % 初始学习率

'LearnRateSchedule', 'piecewise', ... % 学习率调整

'LearnRateDropPeriod', 6, ... % 训练次后开始调整学习率

'LearnRateDropFactor',0.2, ... % 学习率调整因子

'L2Regularization', L2Regularization, ... % 正则化参数

'ExecutionEnvironment', 'gpu',... % 训练环境

'Verbose', 0, ... % 关闭优化过程

'SequenceLength',1,...

'MiniBatchSize',10,...

'Plots', 'training-progress'); % 画出曲线

学习总结

麻雀算法是一种基于卷积神经网络(CNN)和长短期记忆神经网络(LSTM)的预测模型,可以用于多输入单输出的回归预测任务,如麻雀胡牌预测。

该算法的流程如下:

数据预处理。将输入数据进行预处理,如将牌型数据转化为数字、进行归一化、缺失值填充等操作。

卷积网络。对输入数据进行卷积神经网络(CNN)处理,提取其特征表示。

LSTM网络。将卷积网络提取的特征序列输入长短期记忆神经网络(LSTM),将其转化为单一输出。

输出。输出LSTM网络的预测结果。

在该算法中,卷积网络用于提取输入数据的特征,LSTM网络将卷积网络提取的特征序列转化为单一输出,并保留其时间序列信息,从而能够更好地预测未来的结果。

该算法的优化方法主要集中在卷积网络和LSTM网络两个阶段:

卷积网络优化。可以通过增加卷积网络的深度和宽度,增加其表达能力,提高对输入序列的特征提取能力。同时,可以采用更好的激活函数和正则化方法,如ReLU和Dropout,以增加网络的非线性能力和泛化能力。

LSTM网络优化。可以通过增加LSTM网络的隐藏层大小和层数,增加其表达能力和记忆能力,提高对输入序列的建模能力。同时,可以采用更好的门控机制和梯度裁剪方法,如LSTM和Clip Gradient,以增加网络的稳定性和泛化能力。

总之,麻雀算法是一种基于深度学习的预测模型,通过卷积神经网络和长短期记忆神经网络的结合,可以对多输入单输出的回归预测任务进行建模和预测。其优化方法主要包括调整模型结构、优化损失函数和优化算法、融合多个数据源、增加数据预处理和增强、调整模型超参数等。通过这些优化方法,可以提高模型的预测性能和泛化能力,适应更广泛的应用场景。

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/128577926?spm=1001.2014.3001.5501

[2] https://blog.csdn.net/kjm13182345320/article/details/128573597?spm=1001.2014.3001.5501

U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... SpringSecurity实现前后端分离认证授权

SpringSecurity实现前后端分离认证授权