您现在的位置是:首页 >技术杂谈 >[算法前沿]--009-HuggingFace介绍(大语言模型底座)网站首页技术杂谈

[算法前沿]--009-HuggingFace介绍(大语言模型底座)

简介[算法前沿]--009-HuggingFace介绍(大语言模型底座)

基础介绍

HuggingFace 是一家专注于自然语言处理(NLP)、人工智能和分布式系统的创业公司,创立于2016年。最早是主营业务是做闲聊机器人,2018年 Bert 发布之后,他们贡献了一个基于 Pytorch 的 Bert 预训练模型,即 pytorch-pretrained-bert,大受欢迎,进而将重心转向维护 NLP开源社区。

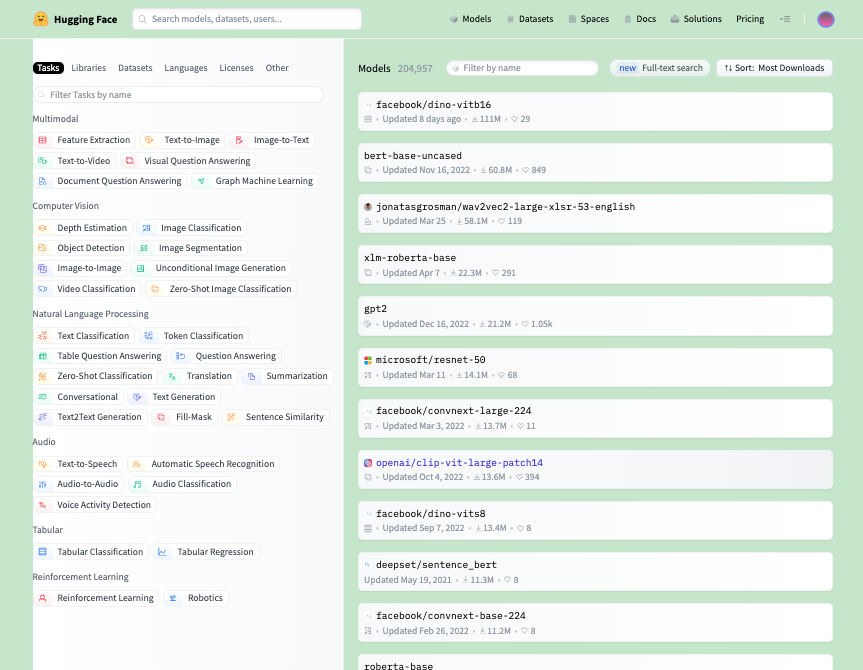

经过这几年的发展,HuggingFace 的开源社区,已经变成了最大的开源模型托管服务的平台,相当于人工智能界的 Github。

官网:https://huggingface.co

HuggingFace里有什么

Models:56000多个预训练模型,BERT、GPT等,甚至还有图像预训练模型。

Datasets:6900多个数据集,文本分类、问答语料等都有,遗憾的是中文的数据集很少。

HuggingFace 正确打开姿势,是当做工具来用,无需花时间系统了解,按需学习即可。

我们这课程,也是一个连载的状态,项目中需要用到某个模块或者数据集,才会针对性讲解某一块内容。大家有特别想了解的内容,也可以留言告诉我,我抽时间补充。

快速安装

transformers 是一个通用接口,Pytorch, Tensorflow2 都支持,相当于加载预训练模

风语者!平时喜欢研究各种技术,目前在从事后端开发工作,热爱生活、热爱工作。

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结