您现在的位置是:首页 >技术教程 >mmFormer:用于脑肿瘤分割的不完全多模态学习的多模态医学Transformer网站首页技术教程

mmFormer:用于脑肿瘤分割的不完全多模态学习的多模态医学Transformer

文章目录

mmFormer: Multimodal Medical Transformer for Incomplete Multimodal Learning of Brain Tumor Segmentation

摘要

背景

从磁共振成像(MRI)中精确分割脑肿瘤对于多模态图像的联合学习是可取的。然而,在临床实践中,并不总是能够获得一套完整的MRI,并且缺失模式的问题导致现有多模式分割方法的性能严重下降。

本文方法

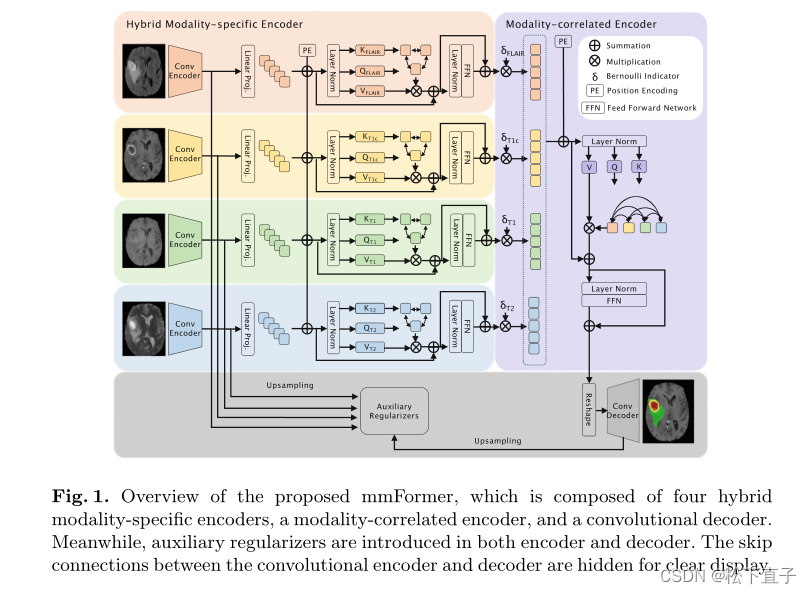

- 首次尝试利用Transformer进行多模态脑肿瘤分割,该分割对任何可用模态的组合子集都是鲁棒的。

- 提出了一种新的多模态医学转换器(mmFormer),用于不完全多模态学习

- 三个主要组件:桥接卷积编码器和模态内转换器的混合模态专用编码器,用于在每个模态内进行局部和全局上下文建模;

- 模态间变换器,用于为模态不变特征建立跨模态的长程相关性并将其与对应于肿瘤区域的全局语义对齐;

本文方法

Hybrid Modality-Specific Encoder

混合模态专用编码器旨在通过桥接卷积编码器和模态内变换器来提取特定模态内的局部和全局上下文信息

Convolutional Encoder

卷积编码器是通过堆叠卷积块来构建的,类似于U-Net的编码器部分

构建了一个五级编码器,每个级由两个卷积块组成。每个块包含级联的组归一化、ReLU和核大小为3的卷积层,而第一阶段中的第一个卷积块仅包含卷积层。在两个连续块之间,采用步长为2的卷积层来对特征图进行下采样。编码器的每一级的滤波器数量分别为16、32、64、128和256。

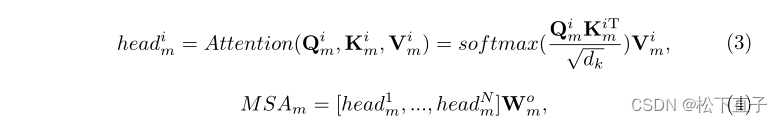

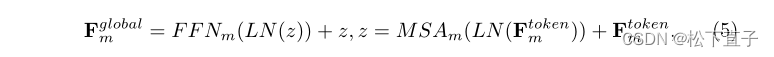

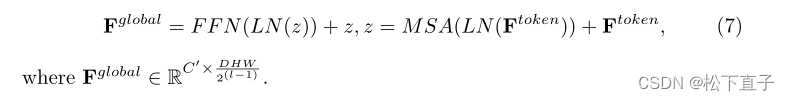

Intra-modal Transformer

当Transformer以序列到序列的方式处理嵌入时,卷积编码器产生的局部特征图Flocalm首先被展平为1D序列,并通过线性投影转换到令牌空间

然而,平坦化操作不可避免地会使空间信息崩溃,这对图像分割至关重要。为了解决这个问题,我们引入了一种可学习的位置嵌入Pm,以通过逐元素求和来补充平坦特征,其公式为

Modality-Correlated Encoder

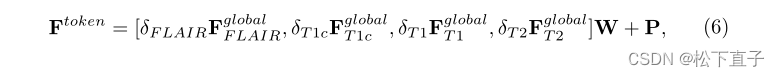

模态相关编码器被设计为建立模态之间的长程相关性,用于具有与肿瘤区域相对应的全局语义的模态不变特征。它被实现为一个模态间转换器。

与模态内变换器不同,模态间变换器通过级联将来自所有模态特定编码器的嵌入组合为输入多模态令牌,其定义为

Convolutional Decoder

卷积解码器被设计为将空间分辨率从高级潜在空间逐渐恢复到原始掩模空间。模态相关变换器的输出序列Fglobal被重新整形为与平坦化之前的大小相对应的特征图。卷积解码器具有卷积编码器的对称架构,类似于U-Net。此外,还增加了编码器和解码器之间的跳过连接,以保留更多的低级别细节,从而更好地进行分割。来自特定级别的不同模态的卷积编码器的特征被级联并作为跳过特征转发到卷积解码器。

Auxiliary Regularizer

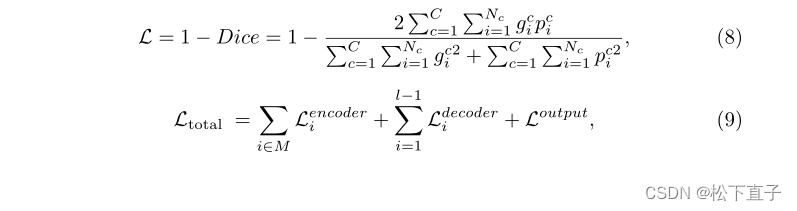

传统的多模式学习模型往往依赖于判别模式来识别脑肿瘤。当辨别模式缺失时,这类模型可能会面临严重的退化。因此,即使没有其他模式的帮助,也必须鼓励每个卷积编码器对脑肿瘤进行分割。为此,卷积编码器的输出由共享权重解码器上采样,以分别从每个模态中分割肿瘤。共享权重解码器具有与卷积解码器相同的架构。此外,我们还在卷积解码器中引入辅助正则化子,以迫使解码器即使在缺少某些模态的情况下也能生成准确的分割。它是通过在卷积解码器的每个阶段内插特征图来实现的,以通过深度监督来分割肿瘤。dice损失被用作正则化子。将网络输出的训练损失作为

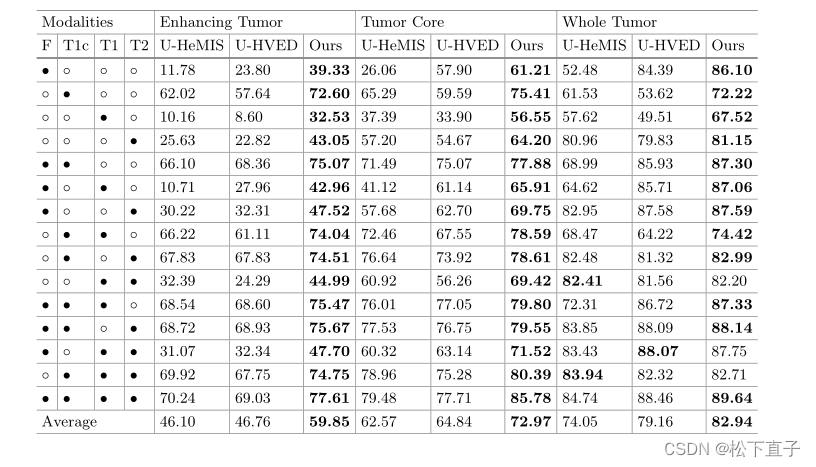

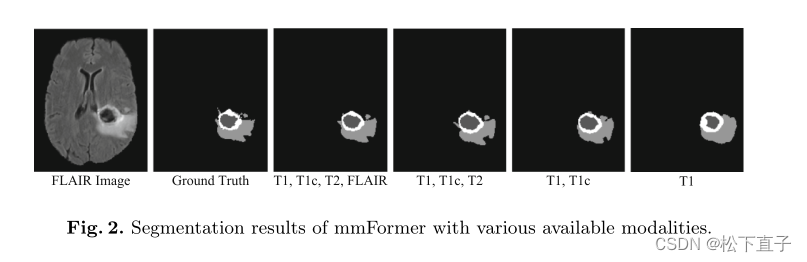

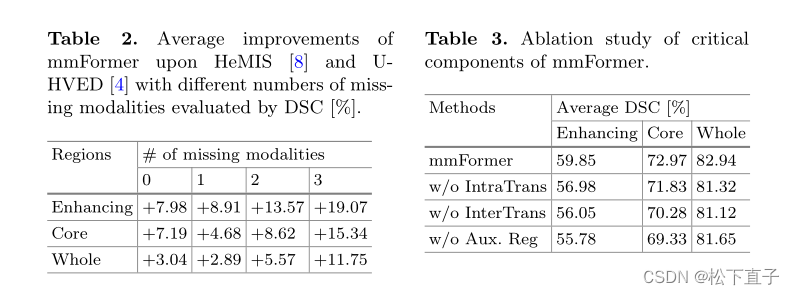

实验结果

U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结