您现在的位置是:首页 >技术教程 >视频理解AI模型分类与汇总网站首页技术教程

视频理解AI模型分类与汇总

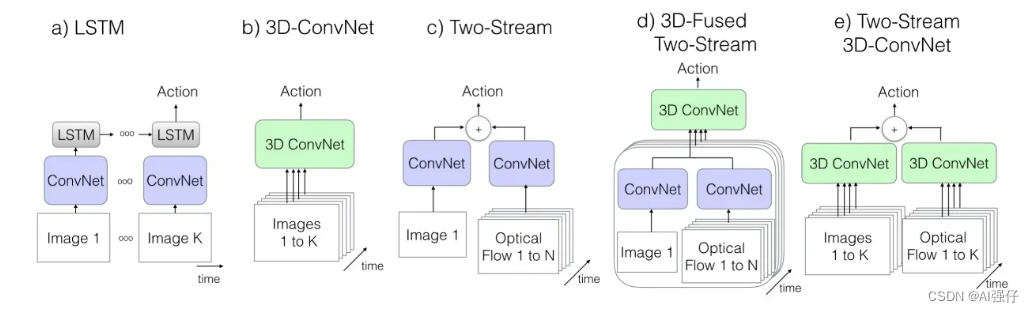

人工智能领域视频模型大体也经历了从传统手工特征,到卷积神经网络、双流网络(2014年-2017年)、3D卷积网络、transformer的发展脉络。为了时序信息,有的模型也结合用LSTM。

视频的技术大多借鉴图像处理技术,只是视频比图片多了一个时间维度。

下面内容先简单汇总下,后续再逐渐补充。

0.传统特征

0.1 STIP

该特征来源于论文《On space-time interest points》,该特征是时空兴趣点的经典特征。

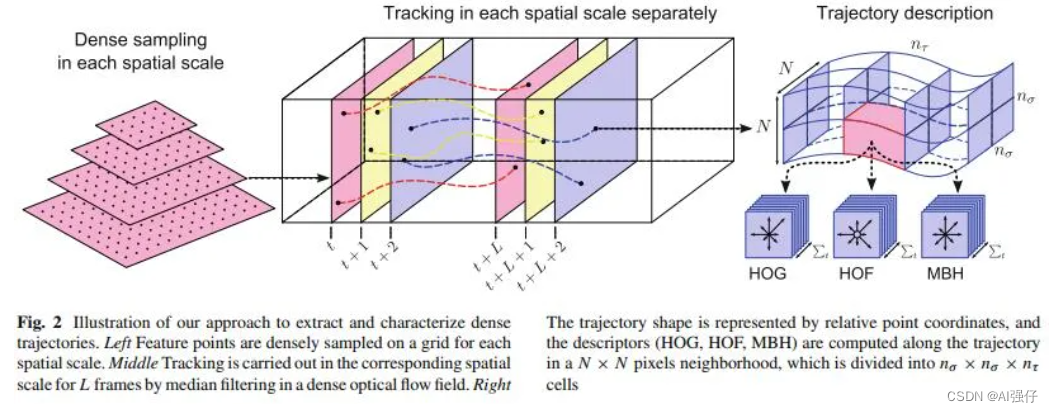

0.2 improved dense trajectories(iDT)

iDT算法是行为识别领域中非常经典的一种算法,在深度学习应用于该领域前也是效果最好的算法。由INRIA的IEAR实验室于2013年发表于ICCV。目前基于深度学习的行为识别算法效果已经超过了iDT算法,但与iDT的结果做ensemble总还是能获得一些提升.

"Dense Trajectories and Motion Boundary Descriptors for Action Recognition"和"Action Recognition with Improved Trajectories"。这两篇都是H. Wang的文章,前者要更早一些,介绍了DT(Dense Trajectories)算法。后者则在前者的基础上进行了改进(improved),主要是引入了对背景光流的消除方法,使得特征更集中于对人的运动的描述。两者的框架大致相同。

算法的基本框架,包括密集采样特征点,特征点轨迹跟踪和基于轨迹的特征提取几个部分。

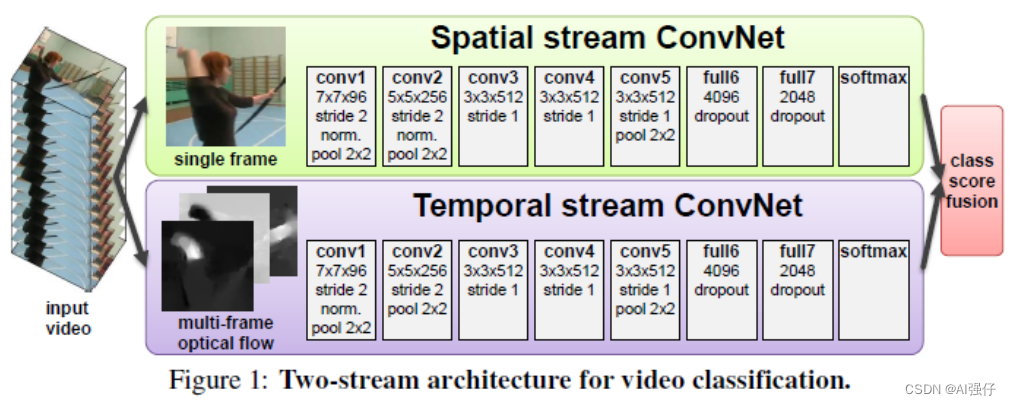

1. 双流网络

1.1 双流网络

通过 Spatial stream ConvNet 和 Temporal stream ConvNets 分别抽取视频的空间和时序特征,最后对两个网络进行融合。详见《Two-stream architecture for video recognition》

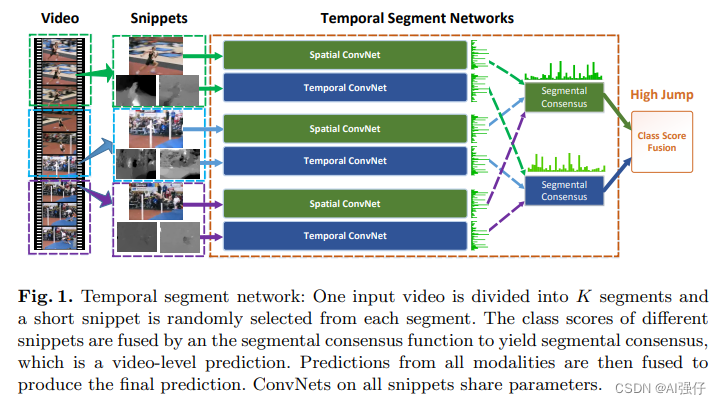

1.2 TSN

Temporal Segment Networks。将视频分成多段,分别输入到双流网络。如下图分成了3段。

2. 3D卷积

视频比图片多了个时间维度,故将图片的2D卷积可以扩展到3D,处理视频。

详见论文笔记3D Convolutional Neural Networks for Human Action Recognition_AI强仔的博客-CSDN博客

2.1 I3D

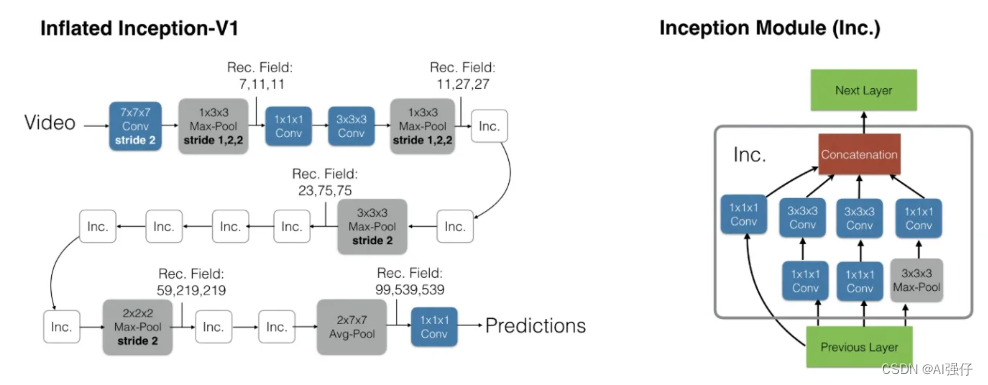

Two-Stream Inflated 3D ConvNets (I3D) :将2D网络膨胀为3D网络,使得视频理解不需要再耗费心神去设计一个专门的网络了,而是可以直接使用图片预训练好的模型甚至是预训练的参数。

3. transformer

最近的研究主要集中在3D卷积神经网络和视觉transformer。虽然3D卷积可以在一个小的3D领域内(如3*3*3)可以捕捉详细的局部时空特征,减少了相邻帧之间的时空冗余,即有效处理局部信息来控制局部冗余,但因为受限制的接受域,缺乏捕捉全局依赖的能力。而视觉transformer通过自注意力机制可以捕捉长范围的依赖,但又在每个层中所有token的盲目相似比较导致其不能很好的减少局部冗余。

3.1 UNIFORMER-视频模型(3D CNN和transformer结合)

Unifified transFormer (UniFormer) ,集成了3D卷积和transformer,在计算量和准确度之间取得了较好的平衡。可以同时处理时空冗余和依赖.

详见UNIFORMER-视频模型(3D CNN和transformer结合)_AI强仔的博客-CSDN博客

4. 数据集

4.1 UCF101

已被刷爆。

4.2 HMDB51

已被刷爆。

U8W/U8W-Mini使用与常见问题解决

U8W/U8W-Mini使用与常见问题解决 QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。...

QT多线程的5种用法,通过使用线程解决UI主界面的耗时操作代码,防止界面卡死。... stm32使用HAL库配置串口中断收发数据(保姆级教程)

stm32使用HAL库配置串口中断收发数据(保姆级教程) 分享几个国内免费的ChatGPT镜像网址(亲测有效)

分享几个国内免费的ChatGPT镜像网址(亲测有效) Allegro16.6差分等长设置及走线总结

Allegro16.6差分等长设置及走线总结